- Поисковые системы

- Практика оптимизации

- Трафик для сайтов

- Монетизация сайтов

- Сайтостроение

- Социальный Маркетинг

- Общение профессионалов

- Биржа и продажа

- Финансовые объявления

- Работа на постоянной основе

- Сайты - покупка, продажа

- Соцсети: страницы, группы, приложения

- Сайты без доменов

- Трафик, тизерная и баннерная реклама

- Продажа, оценка, регистрация доменов

- Ссылки - обмен, покупка, продажа

- Программы и скрипты

- Размещение статей

- Инфопродукты

- Прочие цифровые товары

- Работа и услуги для вебмастера

- Оптимизация, продвижение и аудит

- Ведение рекламных кампаний

- Услуги в области SMM

- Программирование

- Администрирование серверов и сайтов

- Прокси, ВПН, анонимайзеры, IP

- Платное обучение, вебинары

- Регистрация в каталогах

- Копирайтинг, переводы

- Дизайн

- Usability: консультации и аудит

- Изготовление сайтов

- Наполнение сайтов

- Прочие услуги

- Не про работу

Как удалить плохие SEO-ссылки и очистить ссылочную массу сайта

Применяем отклонение ссылок

Сервис Rookee

VK приобрела 70% в структуре компании-разработчика red_mad_robot

Которая участвовала в создании RuStore

Оксана Мамчуева

Новый сайт исключено! Новый сайт разрабатываться не будет. Так как уже есть Клиентская база, и размещены в нескольких торговых площадках

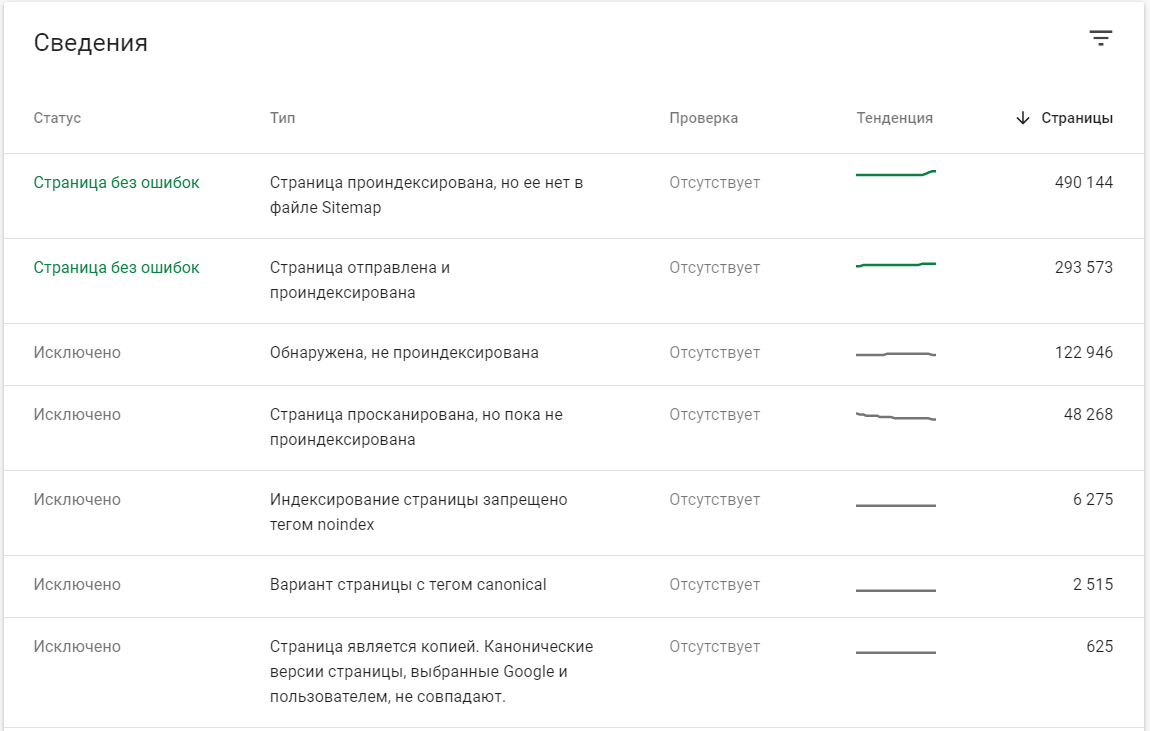

Подтверждено то, что если не заняться исключением таких страниц (вплоть до полного удаления по URL), движений по вашему сайту не будет :) Зачем Google расходовать краулинговый лимит на ваш сайт и в частности на туманное количество ГС-страниц?

Не думаю, что всё так плохо. Такие сайты вытягивать можно и нужно. Тут я вижу пока 2 пути.

В любом случае не стоит опускать руки и слушать всепропальщиков-теоретиков. У меня таких страниц в разы больше и ничего, живу.

Многие из тех, которые без ошибок долгое время были не проиндексированы, просто отлёживались, ждали своего времени, многие доси ждут.

Так, что крест на них ставить ещё очень рано.

Желаю успехов!

Не думаю, что всё так плохо. Такие сайты вытягивать можно и нужно. Тут я вижу пока 2 пути.

В любом случае не стоит опускать руки и слушать всепропальщиков-теоретиков-умников. У меня таких страниц в разы больше и ничего, живу.

Многие из тех, которые без ошибок долгое время были не проиндексированы, просто отлёживались, ждали своего времени, многие доси ждут.

Так, что крест на них ставить ещё очень рано.

Желаю успехов!

У меня есть интернет-магазин, где каждая страничка, будь-то карточка или категория, расписана по-википедийски. И вот точь-в-точь такая же ерунда.

У меня есть интернет-магазин, где каждая страничка, будь-то карточка или категория, расписана по-википедийски. И вот точь-в-точь такая же ерунда.

Потому что не всё упирается в контент.

Гуглобот технически имеет ограничения на обход сайта. Вот он получил документ - вот он получил с этого документа список ссылок, которые поставил в очередь на дальнейший обход. И приоритет этим ссылкам он отдаст разный, в соответствии со своими собственными алгоритмами.

Потому что не всё упирается в контент.

Гуглобот технически имеет ограничения на обход сайта. Вот он получил документ - вот он получил с этого документа список ссылок, которые поставил в очередь на дальнейший обход. И приоритет этим ссылкам он отдаст разный, в соответствии со своими собственными алгоритмами.

год назад

сгенерировать немного (параграфа из 3-5 предложений, думаю, будет достаточно, главное не переборщить) уникального релевантного контента

Сгенерировать из 3-5 предложений уникального контента почти на 10K товарных страниц? :) Вы верно шутите.

Сгенерировать из 3-5 предложений уникального контента почти на 10K товарных страниц? :) Вы верно шутите.

нет. Вы меня не верно поняли.

Пардон за офф-топ: А почему, под сообщениями, какие-то левые ссылки автоматом появляются?

По своему опыту, тут время отклика имеет значение. Долго ждать он не любит. Ну а когда дойдёт очередь - он может съесть много, если конечно его принудительно не глушат. Если содержание его заинтересует - плевать он хотел на ограничения.

Мюллер как-то обмолвился, что время ожидания отклика сайта для гуглобота - аж 2 минуты. Он терпеливый. Другое дело, что в реале он может этого и не делать. После пары зависонов пометит документ или хост как чересчур тормозной - и лимит на обходы уменьшит. Вот тебе 5 URL в очередь при заходе раз в неделю - и делай что хочешь.

То же самое и с редиректами. Формально - 20 переходов (насколько я помню). Фактически, судя по логам, может послать сайт уже и на пятом.

Так что да, многое упирается в своего рода "карму" сайта, его техническое состояние, интерес для ползателей, и ещё пачку сигналов.

Так что да, многое упирается в своего рода "карму" сайта

Это всё софистика. Слушайте больше дружище Мюллера и его друганов. Они говорят лишь то, что им дозволено сказать. Так сказать официальную позицию. И это правильно, я бы и сам так делал.

Включите свою логику - никто не любит долго ждать и напрягаться. Ни гуглобот, ни пользователи (для кого вся эта каша заваривается), ни ленивые разрабы.

А, может и правда у ТС банально проблемы с откликом? Он вроде ни словом об этом не обмолвился. Но это я так, в порядке общего бреда.

Вообще я не хочу хвалиться, но каждый запрос ходовой профилирую и анализ EXPLAIN делаю. Где надо ставлю индексы, где не надо убираю и т.д., стараюсь уменьшить длину ключа, не делать лишних запросов, провожу нормализацию/денормализацию данных (не всегда удачно, правда) т.к. каждая мсек у меня на счету.

Вообще на больших данных не ошибки неизбежны. Инженерная точность 10%. Если ошибки в этом пределе - стараюсь не замечать проблемы, откладываю на потом, иду дальше не зацикливаясь.

По моему, чем более оптимизировано информационное обеспечение, тем лучше всем - и процессор меньше напрягается, не выполняя левых команд, и гуглобот меньше ждёт своей очереди, и пользователь (что самое главное), да и мне быстрее отлаживать.

Вы меня не верно поняли.

Тогда пожалуйста разверните более доходчиво свою мысль и лучше на живых примерах, чтобы стало понятно, каким образом вы предлагаете программно уникализировать тысячи страниц с помощью 3-5 предложений.

Пардон за офф-топ: А почему, под сообщениями, какие-то левые ссылки автоматом появляются?

Для внедрения заголовков доп. тем в контекст переписки.