- Поисковые системы

- Практика оптимизации

- Трафик для сайтов

- Монетизация сайтов

- Сайтостроение

- Социальный Маркетинг

- Общение профессионалов

- Биржа и продажа

- Финансовые объявления

- Работа на постоянной основе

- Сайты - покупка, продажа

- Соцсети: страницы, группы, приложения

- Сайты без доменов

- Трафик, тизерная и баннерная реклама

- Продажа, оценка, регистрация доменов

- Ссылки - обмен, покупка, продажа

- Программы и скрипты

- Размещение статей

- Инфопродукты

- Прочие цифровые товары

- Работа и услуги для вебмастера

- Оптимизация, продвижение и аудит

- Ведение рекламных кампаний

- Услуги в области SMM

- Программирование

- Администрирование серверов и сайтов

- Прокси, ВПН, анонимайзеры, IP

- Платное обучение, вебинары

- Регистрация в каталогах

- Копирайтинг, переводы

- Дизайн

- Usability: консультации и аудит

- Изготовление сайтов

- Наполнение сайтов

- Прочие услуги

- Не про работу

Как снизить ДРР до 4,38% и повысить продажи с помощью VK Рекламы

Для интернет-магазина инженерных систем

Мария Лосева

любой самый корявый и убогий клик по выдаче по ключу до января точно подымал а не опускал. даже если клик в итоге до сайта не дошел.

Нет. Я проверял. Специально под это дело в том году сделал сайт дабы попробовать.

То есть, чтобы даже отказаться от учёта ПФ в данном случае, нужно потратить ресурсы, чтобы понять, что эта ситуация ненормальная и её не нужно учитывать. И встаёт вопрос - каким образом это понять? Как отличить 10 кликов колёсиком мыши от обычных кликов? Или как понять, посмотрел человек вкладку или не посмотрел?

Ну не отказаться. Если посмотреть доклад (который "Through the looking glass...") и те метрики Матрикснета, что имеют отношение к ПФ, то логика там достаточно прозрачная. Нерелевантный документ можно яростно прокликивать, и это может даже дать какой-то временный эффект. Но если по факту там всё плохо - то никакой last-click ничего не даст, кроме бана.

Кроме того, это же логарифмы, которые перемалывают информацию на больших объёмах, и всё это базируется на самой примитивной логике. Сколько юзверей откроет десять вкладок? Все эти 10 сайтов (если выдача однородная, не спектр) - примерно одно и то же, разница - в логотипах. Ну, посчитают этот last-click всем, делов-то. На фоне того, что вот сюда это уже не первый визит, а этот ранжируется по более объёмному запросному индексу в заданном кластере, а тут вхождений больше чисто на ассортименте всё определит вес совокупных метрик в формуле.

Если дыру найдут в CMS и конкуренты трояна запихнут на многие сайты, это тоже должны понимать и не вводить нарушение?

Если запихнут трояна - это вы должны заниматься чистоплотностью и надежностью своего сайта, это разные вещи

Простите за длинный пост. Хочется узнать - это точно боты?, как проверить наверняка? (а то до последнего тешу себя мыслью, что это сайт такой хороший и его аудитория любит :) )

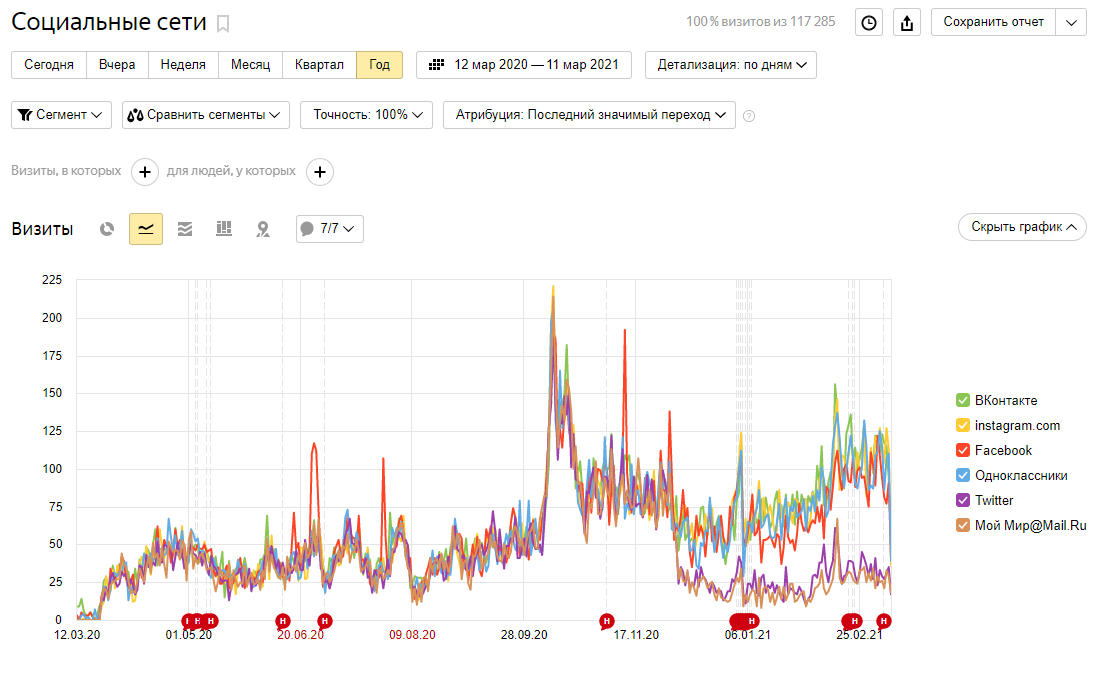

Сегодня полистал топик и проверил свою метрику. Всплеск из соц. сетей был в начале 2020 года (до этого +/- 0). Держатся ровно почти все сети:

С начала Октября 2020 попер трафик с прямыми заходами:

в эти же дни увеличилось количество пользователей с блокировщиком рекламы (хоть тема сайта и не предполагает "продвинутых пользователей пи-си", аудитория Ж40+):

ПСы по разному отнеслись к прямым заходам - Гугл через 2 недели начал наливать трафик; Яндекс мнется на месте:

Собственно вопросы:

Почему прямые заходы увеличиваются "естественной" линией вверх, а не рывком?

Потому что бототраф "доливают" постепенно, без палева. Вам-то его льют мимоходом, по пути.

То, что это бототраф, думаю, сомнений нет.

Чем это чревато в перспективе для сайта?

Мало данных. Просто выгул ботов не опасен, это просто лишняя нагрузка на ваш сервер.

А вот если пошёл фрод - тогда ой. Смотрите на запросы, по которым идут, и в Метрике, и в Вебмастере, на изменения в их характеристиках (отказы, ctr и т.п.).

а у тебя уже есть заходящие из серпа?

Они есть на любом сайте сейчас. Интенсивность только может быть разная.

Если запихнут трояна - это вы должны заниматься чистоплотностью и надежностью своего сайта, это разные вещи

С каких первых страниц темы, это выдрано не понимая вообще о чём разговор был?

Именно, владелец сайта и должен этим заниматься и блокировать ботный трафик а так же не ставить сомнительных аддонов чтобы невзломали.

Просто выгул ботов не опасен, это просто лишняя нагрузка на ваш сервер.

Враньё в эфире. Бототраф портит ПФ сайту, портит метрики у сайта, никаким поисковикам и рекламным системам ненужен сайт с грязным трафиком.

Ну не отказаться. Если посмотреть доклад (который "Through the looking glass...") и те метрики Матрикснета, что имеют отношение к ПФ, то логика там достаточно прозрачная. Нерелевантный документ можно яростно прокликивать, и это может даже дать какой-то временный эффект. Но если по факту там всё плохо - то никакой last-click ничего не даст, кроме бана.

Кроме того, это же логарифмы, которые перемалывают информацию на больших объёмах, и всё это базируется на самой примитивной логике. Сколько юзверей откроет десять вкладок? Все эти 10 сайтов (если выдача однородная, не спектр) - примерно одно и то же, разница - в логотипах. Ну, посчитают этот last-click всем, делов-то. На фоне того, что вот сюда это уже не первый визит, а этот ранжируется по более объёмному запросному индексу в заданном кластере, а тут вхождений больше чисто на ассортименте всё определит вес совокупных метрик в формуле.

Я к чему вообще об этом начал говорить - есть такой вот сайт:

Видимость в Яндексе:

Да, в то же время у него была часть ботов из поиска, но их было очень мало (где-то 5-10% от всех ботов). Просел он после всплеска прямых заходов и соцсетей.

Проседал примерно так:

То есть в 2 этапа:

1) Весной просто просел.

2) Летом вообще вылетел.

Причём, летом он вылетел не просто так, а именно в тот день, когда наказали накрутчиков ПФ - https://www.seonews.ru/events/analiziruem-vydachu-yandeksa-v-poiske-samyy-bolshoy-shtorm-za-kvartal/

И на этом дело не кончилось - 20-го сентября сайт вообще вылетел из поиска по всем запросам, в том числе по витальным (название компании и адрес домена):

Нетрудно догадаться, что на картинке по вертикали чередуются позиции в Яндексе и Гугле. После недельного препирательства с Платоном, сайт всё-таки восстановили по витальным запросам. На вопрос о том, что это было, был получен ответ:

Хотя вылет произошёл во время сентябрьской порки за накрутку ПФ - https://www.seonews.ru/events/yandeks-vozobnovil-pokazatelnye-porki-za-nakrutku-povedencheskikh-faktorov/

Подобный кейс описывал Людкевич - https://searchengines.guru/ru/articles/2048937

В итоге сайт пострадал в 3 этапа:

1) В апреле просел.

2) В июле улетел за топ-50 в день наказания накрутчиков ПФ.

3) В сентябре вылетел по всем запросам (опять же - в канун порки за накрутку ПФ), но был амнистирован Платоном.

В последствии сайту маленько нарастили ссылочной массы, после чего в Гугле он встал в топ-1 почти по всем запросам:

Вот такие пироги. Я это всё к тому, что даже если одними прямыми заходами сайт не завалить, то при добавлении буквально даже чуть-чуть бот-трафика из поиска, сайт улетает. А сайт был в топе (как сейчас в Гугле). Возможно, если бы изначально был исключён бот-трафик хотя бы не из поиска, то сайт до сих пор был бы в топе.