- Поисковые системы

- Практика оптимизации

- Трафик для сайтов

- Монетизация сайтов

- Сайтостроение

- Социальный Маркетинг

- Общение профессионалов

- Биржа и продажа

- Финансовые объявления

- Работа на постоянной основе

- Сайты - покупка, продажа

- Соцсети: страницы, группы, приложения

- Сайты без доменов

- Трафик, тизерная и баннерная реклама

- Продажа, оценка, регистрация доменов

- Ссылки - обмен, покупка, продажа

- Программы и скрипты

- Размещение статей

- Инфопродукты

- Прочие цифровые товары

- Работа и услуги для вебмастера

- Оптимизация, продвижение и аудит

- Ведение рекламных кампаний

- Услуги в области SMM

- Программирование

- Администрирование серверов и сайтов

- Прокси, ВПН, анонимайзеры, IP

- Платное обучение, вебинары

- Регистрация в каталогах

- Копирайтинг, переводы

- Дизайн

- Usability: консультации и аудит

- Изготовление сайтов

- Наполнение сайтов

- Прочие услуги

- Не про работу

Тренды маркетинга в 2024 году: мобильные продажи, углубленная аналитика и ИИ

Экспертная оценка Адмитад

Оксана Мамчуева

И будет не рабочее. Это сбивается не специально нацеленными на рефспам правилами, а комплексом различных фильтров, в целом против ботов. Естественно, есть основное ядро правил, а есть постоянно дорабатываемые строчки в них, которые добавляются по мере развития боторынка. Задумывался как-то на эту тему, почему оно работает и какое из правил режет рефспам. Потом плюнул - работает и работает.

Если на сайт прут боты с поддельными реферами, то как остальной набор правил поможет отфильтровать данный тафик?

Напишите правило или опишите принцип по которому вы блокируете-фильтруете спам переходы, в которых реферальный сайт подделывается. (В метрике такой трафик в переходы по ссылкам попадает).

а комплексом различных фильтров, в целом против ботов.

Опишите пожалуйста их логику, чтобы было понятно, как можно применить ваш совет с демонстрацией такого результативного скриншота.

Если на сайт прут боты с поддельными реферами, то как остальной набор правил поможет отфильтровать данный тафик?

Напишите правило или опишите принцип по которому вы блокируете-фильтруете спам переходы, в которых реферальный сайт подделывается. (В метрике такой трафик в переходы по ссылкам попадает).

Можете привести конкретные рабочие примеры, чтобы их можно было спроецировать на другие рабочие случаи?

Опишите пожалуйста их логику, чтобы было понятно, как можно применить ваш совет с демонстрацией такого результативного скриншота.

Если совсем вкратце, то баним и фильтруем все то, что здесь и так обсуждается в теме. Только в более расширенном составе, не отдельными несвязанными кусочками. Не 5-10 строчек, как когда-то было на VC и преподносится обычно прямо как Грааль, а 150.

- сканеры, парсеры, спамеры и проч, в том числе то что пропускает клауд через белый список, но в наших широтах не нужно

- все что имеет поддельный юзерагент, включая тех кто притворяется ботами поисковиков

- все что обращается туда, куда человек не обращается

- все что выходит за паттерн запроса человеком

- явные (битерика энд компани) и неявные подсети, хостеры и проч

- явные боты

- различные ддос паттерны атак

Сами паттерны, естественно, нарабатываются только практикой решения той или иной задачки, для разных цмс, плюс постоянно появляется/добавляется что-то новое, по мере развития боторынка. Который растет не по дням, а по часам.

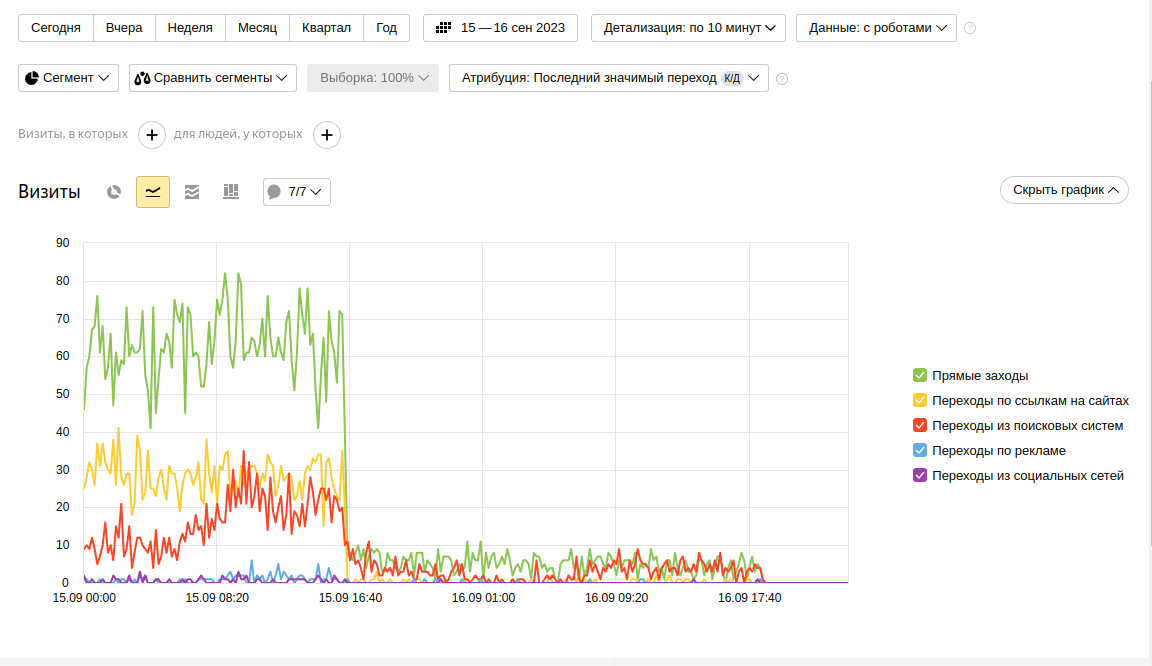

Ну и опять же, на графике четко видно, что и поиск можно подрихтовать. Припали не только прямые заходы, реферальные заходы, но и та часть что через поиск пробирается. Это не подсовывая людям капчу.

Остальное дошлифовывается до устраивающего результата более тонкой настройкой. С изучением логов сервера и метрики, логов клауда.

Если совсем вкратце, то баним и фильтруем все то, что здесь и так обсуждается в теме. Только в более расширенном составе, не отдельными несвязанными кусочками. Не 5-10 строчек, как когда-то было на VC и преподносится обычно прямо как Грааль, а 150.

- сканеры, парсеры, спамеры и проч, в том числе то что пропускает клауд через белый список, но в наших широтах не нужно

- все что имеет поддельный юзерагент, включая тех кто притворяется ботами поисковиков

- все что обращается туда, куда человек не обращается

- все что выходит за паттерн запроса человеком

- явные (битерика энд компани) и неявные подсети, хостеры и проч

- явные боты

- различные ддос паттерны атак

Сами паттерны, естественно, нарабатываются только практикой решения той или иной задачки, для разных цмс, плюс постоянно появляется/добавляется что-то новое, по мере развития боторынка. Который растет не по дням, а по часам.

Ну и опять же, на графике четко видно, что и поиск можно подрихтовать. Припали не только прямые заходы, реферальные заходы, но и та часть что через поиск пробирается. Это не подсовывая людям капчу.

Остальное дошлифовывается до устраивающего результата более тонкой настройкой. С изучением логов сервера и метрики, логов клауда.

Юзер агенты у ботов такие же как у живых пользователей, AS сети тоже могут быть какие угодно, запросы тоже как правило - просто url страницы без доп атрибутов.

Для фильтрации-блокировки прямых заходов проверяют пустого реферера.

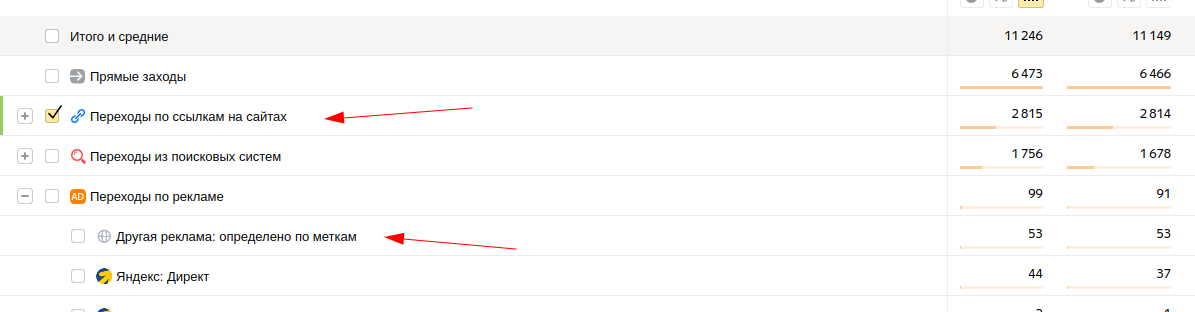

Для фильтрации реф спама (который определятся в метрике Другая реклама: определено по меткам) нужно проверять URI на вхождение utm.

Если знаете как бороться с ботами, у которых поддельный сайт в реферере - напишите что то конкретное.

А то пока просто воду льете.

Юзер агенты у ботов такие же как у живых пользователей,

Я писал вот про такие случаи. Ну или когда пустой юзерагент, либо юзерагент из списка автоматических запросов, наподобие Wpscan или Screaming Frog.

Для фильтрации реф спама (который определятся в метрике Другая реклама: определено по меткам) нужно проверять URI на вхождение utm.

Не вводите в заблуждение. Рефспам отдельно в метрике - переходы с сайтов.

Как вариант - смотреть логи посещений сервера, сравнивать по времени с метрикой, определять айпи и подсеть откуда заход по конкретному переходу якобы с сайта, чтобы вычислить паттерн.

А отчет переходов по рекламе (?utm_source=) - отдельно.

В топике речь про переходы с сайтов.

Требовать конкретное волшебное решение, на конкретный случай - глупо.

Я вроде четко показал, что все возможно, если подходить к вопросу в комплексе.

Я писал вот про такие случаи. Ну или когда пустой юзерагент, либо юзерагент из списка автоматических запросов, наподобие Wpscan или Screaming Frog.

Не вводите в заблуждение. Рефспам отдельно в метрике - переходы с сайтов.

А что я не так написал? Поддельные utm метки - это не рекламный реферер?

Как вариант - смотреть логи посещений сервера, сравнивать по времени с метрикой, определять айпи и подсеть откуда заход по конкретному переходу якобы с сайта, чтобы вычислить паттерн.

Я писал выше, что по IP и AS num такие визиты не вычистить, т.к сети и IP могут быть какие угодно.

Требовать конкретное волшебное решение, на конкретный случай - глупо.

Я вроде четко показал, что все возможно, если подходить к вопросу в комплексе.

В смысле требовать волшебное решение? Вы же в этой ветке написали, что знаете рабочий способ.

Показал четко - это графики метрики? У меня тоже был наплыв трафика с переходов по ссылкам 2-3 мес, потом сам пропал. Так, что такие графики могу и я выложить.

Пока вы никого конкретного решения не предложили, уверен что у вас его нет.

Просто пытаетесь в очередной раз прорекламировать свою платную услугу по настройке CF, которая ничем не отличается от инструкция, которая есть на vc.ru

У меня тоже был наплыв трафика с переходов по ссылкам 2-3 мес, потом сам пропал. Так, что такие графики могу и я выложить.

"У него был триппер, а потом пропал". Ⓒ

Да я понял, что забалтывать уводить тему в сторону вы умеете. Все время вспоминая те гральные начальные неск строчек с VC. Просто ничего другого лично вы и не видели, поэтому и льете воду.

Для всех остальных еще раз повторю. Волшебных методов не бывает, но если подходить комплексно, то вполне реально зацепить подрезать и то, что вроде как напрямую не подрезать.

Просто пытаетесь в очередной раз прорекламировать свою платную услугу по настройке CF, которая ничем не отличается от инструкция, которая есть на vc.ru

Так и есть, от него никакой информации кроме "вы все не разбираетесь, а у меня комплексный подход" нет. Его чудесный и секретный способ максимум в том, чтобы перебанить то, что по сути и не мешает + половину московского региона вместе с нормальными пользователями.

У меня тоже есть "секретный" способ, который за неделю на одном из сайтов дал снижение роботности по метрике с 5% до 0%, но по факту боты просто переключились на заходы с Яндекса.