- Поисковые системы

- Практика оптимизации

- Трафик для сайтов

- Монетизация сайтов

- Сайтостроение

- Социальный Маркетинг

- Общение профессионалов

- Биржа и продажа

- Финансовые объявления

- Работа на постоянной основе

- Сайты - покупка, продажа

- Соцсети: страницы, группы, приложения

- Сайты без доменов

- Трафик, тизерная и баннерная реклама

- Продажа, оценка, регистрация доменов

- Ссылки - обмен, покупка, продажа

- Программы и скрипты

- Размещение статей

- Инфопродукты

- Прочие цифровые товары

- Работа и услуги для вебмастера

- Оптимизация, продвижение и аудит

- Ведение рекламных кампаний

- Услуги в области SMM

- Программирование

- Администрирование серверов и сайтов

- Прокси, ВПН, анонимайзеры, IP

- Платное обучение, вебинары

- Регистрация в каталогах

- Копирайтинг, переводы

- Дизайн

- Usability: консультации и аудит

- Изготовление сайтов

- Наполнение сайтов

- Прочие услуги

- Не про работу

Тренды маркетинга в 2024 году: мобильные продажи, углубленная аналитика и ИИ

Экспертная оценка Адмитад

Оксана Мамчуева

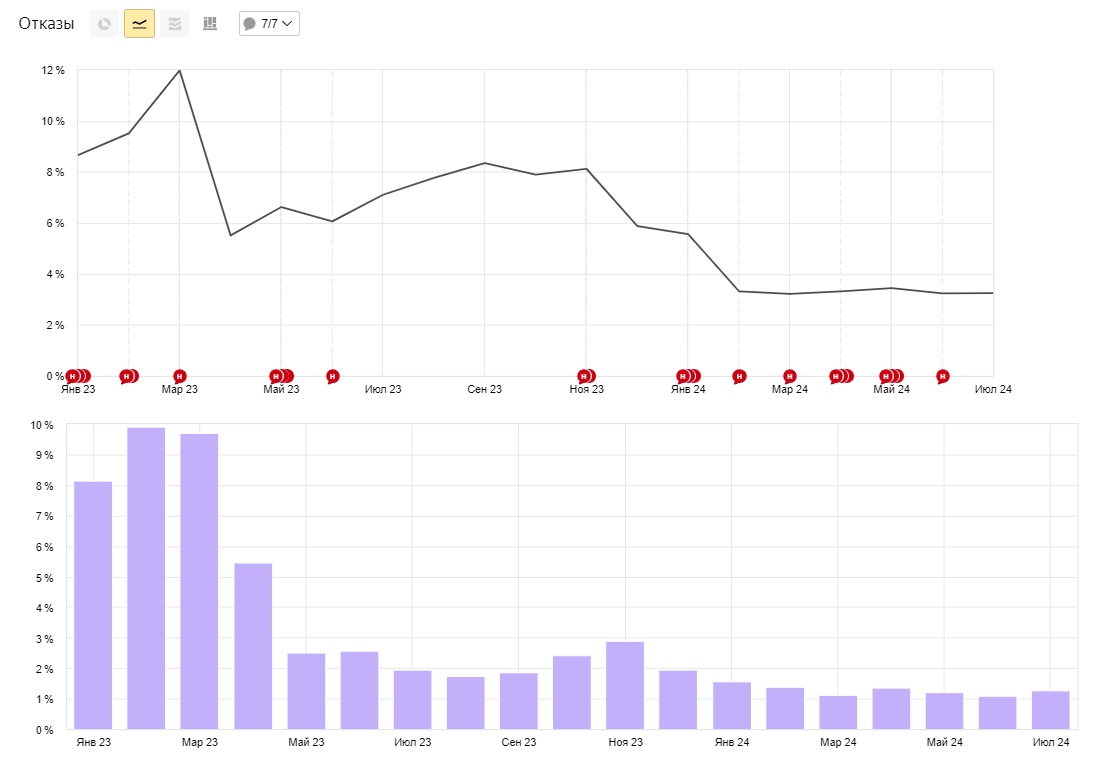

Можно взглянуть на это с другой стороны: нет смысла сравнивать размеры сайта. Если каждая статься будет настолько качественной, что будет закрывать все запросы (а это большой труд с экспертизой), то не имеет смысла 10 статей на сайте или 5к статей. Они все будут генерировать минимальное число отказов.

Если отказы растут, то это не проблема ПС: Яндекс гонит говнотраф с ростом траста сайта, а проблема вебмастера: начинает недорабатывать по контенту, начинает не вывозить технически (боты, верстка, настройка сервера и т.д.).

Ох, ну вы так за Яндекс заступаетесь, прям грудью встали))

Откуда эти растущие отказы то взялись? Речь вроде шла про но 10...15% за норму, вы говорите - норма 2...5%) Как и говорили выше, при трафике 5+к посетителей в сутки не возможно добиться такого показателя отказов (по крайней мере я таких сайтов не встречал). У меня эти примерно 10...11% с самого рождения сайта (4 года) так и стоят. Большинство моих конкурентов имеют отказы 100% выше и они сейчас ранжируются лучше меня, хотя там частенько ГСы еще те

Ну или я что-то не понимаю... поделитесь практикой, как вы на трафике, допустим 5к в сутки, ежедневно отделяете и блокируете доступ к сайту ботов?

Ох, ну вы так за Яндекс заступаетесь, прям грудью встали))

Видать его не коснулось, а мб и в рост ушел, по этому ситуация устраивает и пытается выгораживать ее. А по факту, даже если погуглить, то везде пишут, что нормальный процент отказов по метрике до 15% , 1-4% это заоблачный показатели, такого наверное нигде нет.

Откуда эти растущие отказы то взялись? Речь вроде шла про но 10...15% за норму, вы говорите - норма 2...5%) Как и говорили выше, при трафике 5+к посетителей в сутки не возможно добиться такого показателя отказов (по крайней мере я таких сайтов не встречал). У меня эти примерно 10...11% с самого рождения сайта (4 года) так и стоят. Большинство моих конкурентов имеют отказы 100% выше и они сейчас ранжируются лучше меня, хотя там частенько ГСы еще те

Где я сказал про "Норма 1-2%"? Я написал, что на моих сайтах такой показатель.

Привел пример даже нового сайта (но там 3-4% и я сейчас его не веду, передал владельцу, он продолжает по дорожной карте), созданного тогда, когда у всех все поплыло (и у него тоже плыло). И написал как я это сделал (ботов порезал, с контентом работал). Ну что мне, зайти в админку сайтов и за вас сделать? ;)

1. Отказы.

2. Роботы.

Траф 14к / сутки.

Ну или я что-то не понимаю... поделитесь практикой, как вы на трафике, допустим 5к в сутки, ежедневно отделяете и блокируете доступ к сайту ботов?

Трафик больше, сканирую, обрабатываю, фильтрую - ничего сложного. Но как это сделать - не поделюсь. Чем меньше сайтов - тем больше трафика мне.

Тут, как говорится, пчелы против меда? ;))))

Видать его не коснулось, а мб и в рост ушел, по этому ситуация устраивает и пытается выгораживать ее. А по факту, даже если погуглить, то везде пишут, что нормальный процент отказов по метрике до 15% , 1-4% это заоблачный показатели, такого наверное нигде нет.

По вебвизору вообще может не быть отказов, а метрика нарисует 35%.

Откуда эти растущие отказы то взялись?

Потому как метрику перевели полностью на асинхрон.

Метрика сейчас даже ловит если ссылка сайта последняя автоматически вбилась в браузере и пользователь закрыл вкладку.

Метрика начала ловить ботов которые накручивают на вашем сайте, боты находятся на сайте до пол секунды.

Это всё отказы.

По вебвизору вообще может не быть отказов, а метрика нарисует 35%.

Вебвизор фиксирует все через пень в кобылу, я бы ему вообще ничего, кроме показа реал тайм карты кликов - не доверил.

Ни раз же мы ловили сервисы на аномалиях. А все почему? - сервисы разные, и прогеры их поддерживающие - разные.

А метрика по UTM из того же юутба в виджет пишет запрос, а в виджет переходов с сайта - не пишет. И все в пределах одного счетчика :D

По логам - переход есть, по метрике: в одном виджете есть, в другом - нет :D

В ТП стандартно: барузер скрыл рефку, бла-бла-бла.

1-4% это заоблачный показатели, такого наверное нигде нет.

У меня вообще нет отказов. 😉

У меня вообще нет отказов. 😉

У меня на одном заброшенном сайте тоже отказов нет. Потому что там трафика 12 человек в сутки. А если траф нормальный и страниц много, там отказы всегда будет на уровне 15-20 или даже больше

У меня на одном заброшенном сайте тоже отказов нет. Потому что там трафика 12 человек в сутки. А если траф нормальный и страниц много, там отказы всегда будет на уровне 15-20 или даже больше

Над контентом надо работать, работу сайта надо контролировать, трафик надо контролировать - тогда сайт не будет болтать в выдаче и отказов будет минимум или вообще их не будет, как у товарища выше.

Над контентом надо работать, работу сайта надо контролировать, трафик надо контролировать - тогда сайт не будет болтать в выдаче и отказов будет минимум или вообще их не будет, как у товарища выше.

А с ботами как актуально боретесь? Cloudflare? Потому как есть ощущение, что с этой армией ботоферм разрулить сейчас всё тяжелее...