- Поисковые системы

- Практика оптимизации

- Трафик для сайтов

- Монетизация сайтов

- Сайтостроение

- Социальный Маркетинг

- Общение профессионалов

- Биржа и продажа

- Финансовые объявления

- Работа на постоянной основе

- Сайты - покупка, продажа

- Соцсети: страницы, группы, приложения

- Сайты без доменов

- Трафик, тизерная и баннерная реклама

- Продажа, оценка, регистрация доменов

- Ссылки - обмен, покупка, продажа

- Программы и скрипты

- Размещение статей

- Инфопродукты

- Прочие цифровые товары

- Работа и услуги для вебмастера

- Оптимизация, продвижение и аудит

- Ведение рекламных кампаний

- Услуги в области SMM

- Программирование

- Администрирование серверов и сайтов

- Прокси, ВПН, анонимайзеры, IP

- Платное обучение, вебинары

- Регистрация в каталогах

- Копирайтинг, переводы

- Дизайн

- Usability: консультации и аудит

- Изготовление сайтов

- Наполнение сайтов

- Прочие услуги

- Не про работу

Маркетинг для шоколадной фабрики. На 34% выше средний чек

Через устранение узких мест

Оксана Мамчуева

Ну и обратная ситуация. Был у конкурента сайт, занимал позиции >30, соответственно ботоводам не интересен. В середине декабря бандит подбросил их в ТОП-1-5 по всем ВЧ/СЧ/НЧ и месяц там продержал, видимо измерял параметры. Через месяц частично понизил, но многие позиции остались в ТОП3-6. С февраля ими таки ботоводы заинтересовались, около 50% заходов прямые (если не врут, конечно), но позиции как вкопанные.

По мне сейчас все сайты перемешивает в диапазоне по 6-12 сайтов, прилеплены только те у которых действительно есть постоянный и чистый трафик.

И я считаю правильно яндекс делает, просто трафик таким перемешиванием больше распределяется по сайтам и более сложней умным ботам ходить на переходы к сайтам.

Только в яндексе не учли, что выборку могут сделать и рано или поздно сайт нужный всё равно появиться на 1 или второй странице...

А вот накручивать отлетевший сайты действительно сложней и искать сайт на 10 или 15 странице это тратить ресурсы..

Поэтому выходит не всех накрутчиков ещё вычислили с 1-3 страницы поиска..

У меня нет турбо. Интернет-магазин.

Я думаю, что если вы когда либо включали турбо страницы то и переспам остался где то в турбо страницах. Я бы включил обновить а потом опять отключил.

Я нигде немогу найти за сколько яндекс времени обновляет полученные данные через метрику.

Скорее всего месяца три, судя по изменениям ИКС ( позиции у меня не падали )

Я думаю, что если вы когда либо включали турбо страницы то и переспам остался где то в турбо страницах.

Бред

Скорее всего месяца три, судя по изменениям ИКС ( позиции у меня не падали )

Вот не понятно, обновляет за месяца 3 но и учитывать может за год. А может просто данные за 3 месяца и те, что больше 3 месяцев уже не влияют.

Тайна.. 😀

Народ, смотрю, активно защищается и, видимо, попадает в руки не тех специалистов:

При переходе с Яндекса error 400, при прямом заходе через инкогнито нормально открывается.Нет, просто настройки nginx неправильные

О-ужас:

Это при переходе с поисковика и в броузере, в котором уже ходил на этот сайт.

Улыбнуло😂

Бред

У меня другая информация.. Что сайты в поиске по многим новым словам в поиске оказываются из за турбо.

Ну бред так бред. 😀

Пока тема наполняется водой, вставлю свои сухие пять копеек.

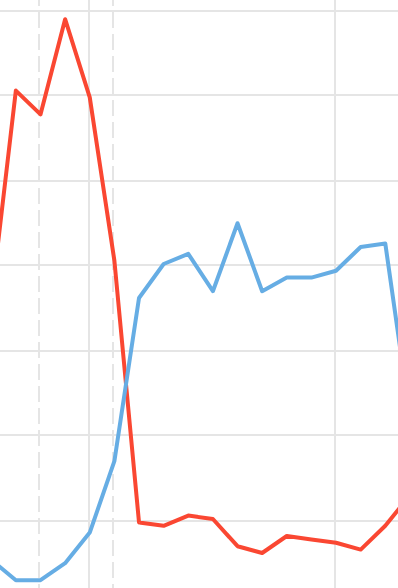

Словил проблему с ботами на сайте с ≈1200 уников в сутки из поиска. Резко вырос трафик по прямым заходам (≈700 в сутки). Через две недели трафик из поиска упал в два раза. В этот момент мы начали предпринимать меры.

В начале отрубили показ метрики юзерам без реффера. Буквально через день боты пошли из закладочного трафика. Отрубили закладочный трафик, пошли по внутренним переходам. Переход внутренний, но визит первый 😂.

Далее шли длительные поиски вычисления ботов. Одновременно с тем как мы научились скрывать метрику от ботов, без разницы откуда лезущих — траф из поиска обрубился еще ×2.

По прошествии недели отсутствия ботов в метрике, трафик ооочень медленно начинает восстанавливаться.

Выводы по блокировке ботов:

1. Есть смысл блокировать показ метрики, но не блокировать сайт.

2. Блокировка на клиенте работает точнее чем на стороне сервера.

3. На js выясняем бот ли это, если да то метрику не инициализируем.

Путём муторной траты времени на аналитику ботового трафика, выявили особенности которыми обладают только боты. Это позволило с нормальной точностью их вычислять (90-95%), не важно каким образом они подделывают переходы. Фишку в паблик сливать не буду, есть ощущение что ботоводы смогут её легко пофиксить.

Повторюсь, сейчас трафик начинает восстанавливаться если тенденция продолжится — кейс можно будет считать позитивным, поделюсь результатами здесь.

Возможно эта инфа кому-то будет полезной. Тут в основном пишут что борьба с ботами результатов не даёт, но в моем случае кажется что смысл в этом есть. Но только в том случае, если боты не ломятся из реальной выдачи.

Вот не понятно, обновляет за месяца 3 но и учитывать может за год. А может просто данные за 3 месяца и те, что больше 3 месяцев уже не влияют.

Из практики за 3 месяца, более трех не учитывает. Но думаю, у всех может быть по разному

У меня траф очень отличается. Прямой и соц. растет и это радует😂