- Поисковые системы

- Практика оптимизации

- Трафик для сайтов

- Монетизация сайтов

- Сайтостроение

- Социальный Маркетинг

- Общение профессионалов

- Биржа и продажа

- Финансовые объявления

- Работа на постоянной основе

- Сайты - покупка, продажа

- Соцсети: страницы, группы, приложения

- Сайты без доменов

- Трафик, тизерная и баннерная реклама

- Продажа, оценка, регистрация доменов

- Ссылки - обмен, покупка, продажа

- Программы и скрипты

- Размещение статей

- Инфопродукты

- Прочие цифровые товары

- Работа и услуги для вебмастера

- Оптимизация, продвижение и аудит

- Ведение рекламных кампаний

- Услуги в области SMM

- Программирование

- Администрирование серверов и сайтов

- Прокси, ВПН, анонимайзеры, IP

- Платное обучение, вебинары

- Регистрация в каталогах

- Копирайтинг, переводы

- Дизайн

- Usability: консультации и аудит

- Изготовление сайтов

- Наполнение сайтов

- Прочие услуги

- Не про работу

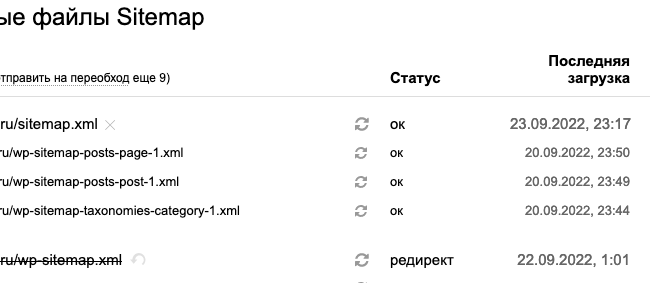

Отправлял обращение в Техподдержку.

Ответили, что данные по сайтмапу обновляются с задержкой.

Так от них не дождешься никогда, самому же надо исправлять их ошибки🤣

В WP Это делается так, добавляем функцию

#меняем карту wp_sitemaps

add_action( 'init', 'add_new_url_main_sitemap' );

add_filter( 'home_url', 'fix_wp_sitemap_url', 11, 2 );

# Добавляет правило с новым адресом карты сайта

function add_new_url_main_sitemap() {

add_rewrite_rule( '^sitemap\.xml$', 'index.php?sitemap=index', 'top' );

}

# Заменяет url с wp-sitemap.xml на sitemap.xml

function fix_wp_sitemap_url( $url, $path ) {

if ( '/wp-sitemap.xml' === $path ) {

return str_replace( '/wp-sitemap.xml', '/sitemap.xml', $url );

}

return $url;

}

Недавно поправил, на сегодняшний день ошибки как и не бывало))

Ребят подскажите пожалуйста, как убрать ошибку Найдены страницы-дубли с GET-параметрами - подскажите какой код прописать в робот.тхт, что бы исключить дубли (стоит вирт март жумла)

Лучше всего такой в htaccess

option, go - вписываете свои значения

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{THE_REQUEST} \?option=(.*)$ [OR]

RewriteCond %{THE_REQUEST} \?go=(.*)$

RewriteRule .* /$0 [R=404,L]

</IfModule>

В роботс, так для /?utm= меток ( если они у вас есть и нужны )

Disallow: *utm*=

Т.е для тех параметров которые нужны, прописываем в роботс, для остальных 404

Ребят подскажите пожалуйста, как убрать ошибку Найдены страницы-дубли с GET-параметрами - подскажите какой код прописать в робот.тхт, что бы исключить дубли (стоит вирт март жумла)

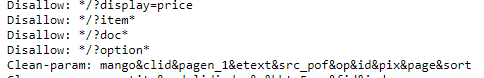

На той же странице вам пишет какие именно параметры. Добавляете в роботс

Clean-param: имя&имя&

Вместо "имя" соответственно параметры. Пример:

Подскажите, пожалуйста, правильно настроил робот

в робот тхт такие параметры сейчас

Clean-param: p0[&p1&p2&..&pn&?&=] [path]

Clean-param: &?&=

disallow: */page/

Disallow: /search #

Disallow: *?s= #

Disallow: *&s= #

Disallow: *utm*=

?option=com_virtuemart&view=manufacturer&virtuemart_manufacturer_id=17&tmpl=component&Itemid=348

Пытался найти все страницы по ключу например "суперпупербренд" и из 10 нашлась только 1. Если искать по точному названию - то пожалуйста каждый можно найти. Куда копать?

Яндекс через фильтр site или host показывает 2000результатов, в вебмастере 10к+. Саппорт говорит "Оператор site: не предназначен для анализа индексирования и ранжирования страниц сайта. "

Правильно говорят. Эти операторы больше не отображают полных данных (в вопросе полноты индексации).

Пытался найти все страницы по ключу например "суперпупербренд" и из 10 нашлась только 1.

Очень может быть, возможно остальные 9 результатов, не проиндексированы, поэтому остальные в результаты и не попадают.

Если искать по точному названию - то пожалуйста каждый можно найти. Куда копать?

Смотря какую задачу вы решаете. Если вы хотите найти все страницы сайта, содержащее искомое слово, то попробуйте воспользоваться контекстным поиском на сайте. Если поиск на сайте работает правильно, то вы сможете более точно решить свою задачу, потому что задавая поиск через индекс вы должны понимать, то будете искать среди проиндексированных страниц, а здесь далеко не факт, что все страницы сайта проиндексированы.

Вебмастер рассылает сообщения "Не удалось подключиться к сайту из-за ошибки сервера". Пришло на 2 сайта.

По логам все окей, YandexBot/3.0 ходит и получает статус 200.

Ошибка связана с отсутствием выпрямителя рук у разработчиков вебмастера.