Автор: Екатерина Хиндикайнен, Product Owner сервиса Rookee

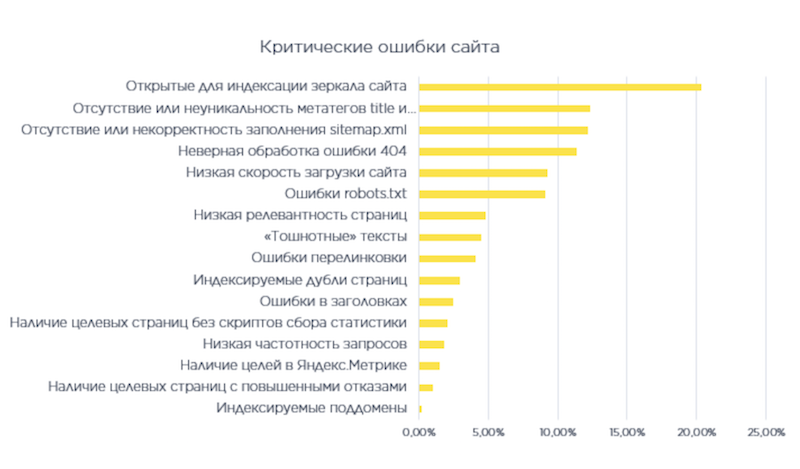

В прошлом году сервис Rookee запустил бесплатную аналитику сайтов, которой уже воспользовались 100 000 веб-ресурсов. Мы проанализировали обобщенные данные за последние полгода и составили топ-10 ошибок SEO. Хотя бы одна из них встречается у 85 % сайтов, на которых проводился аудит. Спорим, у вас тоже есть?

Открытые для индексации зеркала сайта

Лидер среди ошибок — зеркала сайта. Под зеркалами понимаются дубли сайта, которые имеют разные адреса, но одинаковый контент. Зеркала создаются по разным причинам: бронирование нужных доменов, необходимость продвижения в других странах, проведение рекламных кампаний (например, каждый канал должен вести на отдельный лендинг). Но есть одно простое правило: в индексе должно быть только главное зеркало. Если проверка показала наличие зеркал, их нужно удалить или закрыть от индексации.

Чем опасно. Поскольку в поисковой системе будет сразу несколько зеркал, неизвестно, какое из них проиндексируется первым. Остальные будут расценены поисковой системой, как дубли, что автоматически понизит сайт в выдаче.

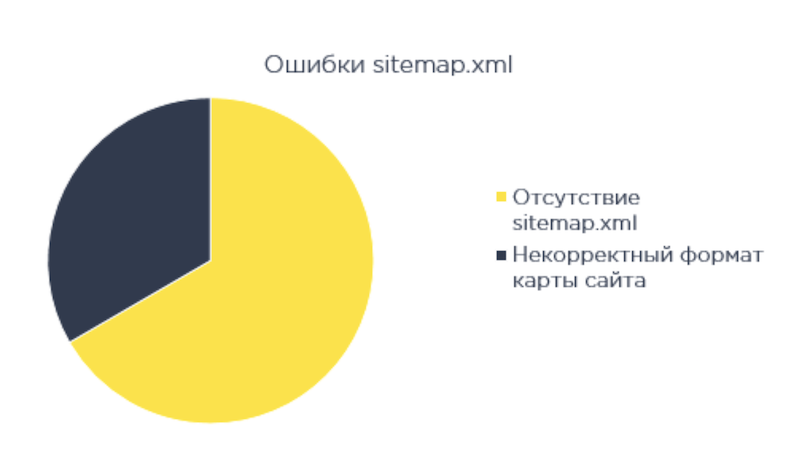

Отсутствие или некорректность заполнения sitemap.xml

Sitemap.xml, или карта сайта — специальный файл, который включает в себя все страницы сайта. Карта сайта создается для удобства поискового робота, чтобы он не пропустил ни одной важной страницы при сканировании. Чем корректнее и полнее этот файл, тем быстрее проходит индексация сайта. Sitemap можно сравнить с оглавлением книги: сразу понятно, что и где смотреть. Если на сайт добавлены новые разделы или страницы, их необходимо сразу занести в sitemap.xml или настроить автоматическую генерацию карты сайта, чтобы новые страницы сразу попадали в sitemap.xml.

Чем опасно. Полное отсутствие или ошибки sitemap.xml затрудняют работу поисковых роботов. Из-за этого некоторые страницы могут быть не проиндексированы, следовательно, не попасть в поиск.

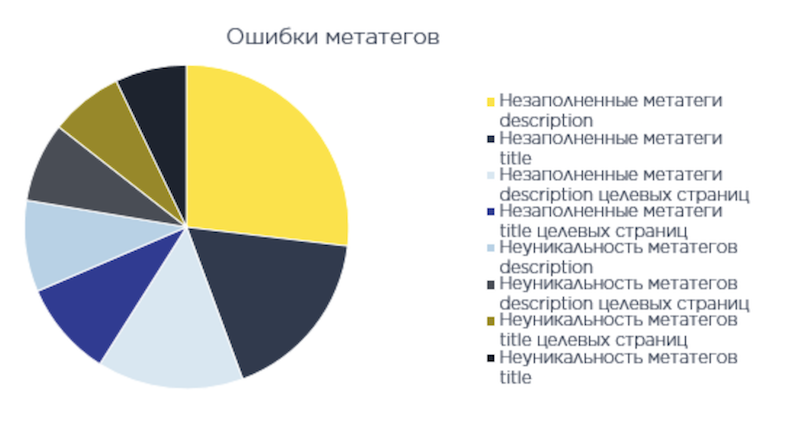

Отсутствие или неуникальность метатегов title и description

Title и description — короли метатегов. Именно с них пользователь начинает знакомство с сайтом. Title — название целевой страницы, оно отображается в заголовке браузера и в поисковой выдаче. Description — краткое описание страницы, на сайте его не видно, но пользователь может прочесть его под title в поисковике. Все целевые страницы в выдаче должны иметь заполненные и уникальные метатеги title и description. Если их нет, пустые места важно заполнить, а дубли — уникализировать.

Чем опасно. Поисковики не терпят пустоты. Если роботы не найдут title и description, они могут подтянуть в заголовок текст из другой части страницы. Кроме того, отсутствие метатегов влияет на оценку качества страницы.

Неверная обработка ошибки 404

Если пользователь переходит по неработающей ссылке или вводит абракадабру в URL, он должен увидеть на экране надпись «Ошибка 404: Данная страница не существует» — стандартный ответ сервера на отсутствующую страницу. На практике часто бывает, что несуществующие страницы отдают роботу ответ нормальной страницы — «200 ОК», или демонстрируют контент, находящийся уровнем выше, например, страницу категорий. Такого быть не должно. Кроме того, на странице с кодом 404 должна быть ссылка на главную страницу, карту сайта и необходимые контактные данные (например почту, телефон для связи), чтобы пользователь мог продолжить путешествие по сайту.

Чем опасно. Большим количеством 404-х страниц недовольны и роботы, и пользователи. Посетитель, который не может быстро найти страницу или перейти на главную, разочаруется и больше не придет. Поисковые роботы воспринимают большое количество ошибок как показатель некачественного сайта и могут понизить ресурс в выдаче.

Низкая скорость загрузки сайта

Хороший сайт — быстрый сайт. Его страницы быстро грузятся, пока пользователь не успеет моргнуть глазом. Если ползунок на сайте крутится несколько секунд, это проблема. Причиной этого могут быть тяжеловесные изображения на сайте, сторонние скрипты, дешевый тариф на хостинге и множество других моментов, учитывать которые очень важно. Чтобы повысить скорость загрузки страницы, важно устранить причину тормозов. например, сжать картинки или перейти на новый тариф.

Чем опасно. Низкая скорость загрузки страниц влияет и на индексацию, и на поведение пользователей. Если робот долго получает контент с сайта, он успевает индексировать меньше страниц за один сеанс. А про пользователей и говорить нечего — в мире мало терпеливых, которые готовы ждать загрузки страницы больше трех секунд.

Ошибки robots.txt

Когда поисковый робот приходит на сайт, он должен понять, какие разделы ему нужно проиндексировать, а какие обойти стороной. Эта информация прописана в файле robots.txt. Форма заполнения этого файла стандартная для любых сайтов. Основная директива User-agent отражает область распространения правила на поисковых ботов Яндекса, Google и других поисковых систем. Кроме того, в файле robots.txt должна быть ссылка на файл на sitemap — путь к файлу с xml-картой.

Чем опасно. Файл robots.txt — это конституция для поисковых ботов. Если его нет, робот может творить все что хочет. А больше всего он желает проиндексировать все страницы сайта: зеркала, корзину, системные каталоги, страницы фильтрации, результаты поиска и др.

Низкая релевантность страниц

Релевантность — это соответствие страницы запросам пользователей в поисковых системах. Высокая релевантность гарантирует, что страница будет в топе выдачи поисковых систем. Технически релевантность рассчитывается как соотношение ключевых слов и фраз к конкретному запросу. Все страницы в продвижении должны иметь высокую релевантность по отношению к ключевым словам, иначе их просто будет не видно в поиске. Повысить релевантность можно за счет внутренней (ключевые слова, метатеги) и внешней (ссылочная масса) оптимизации, юзабилити и наличия необходимых конверсионных элементов на странице.

Чем опасно. Низкая релевантность означает, что страница не находится в топе выдачи по запросу. В итоге вся работа по технической оптимизации идет насмарку.

«Тошнотные» тексты

Текст на страницах сайта должен быть уникальным и с низким уровнем «тошнотности». Если с уникальностью давно разобрались, то с тошнотой сложнее. Тошнота — частота использования слова в тексте. Несколько лет назад считалось: чем больше ключевых слов в тексте, тем сайт выше в поисковой выдаче. Многое изменилось после введения специальных алгоритмов ранжирования. Поисковики научились наказывать за переоптимизированные страницы, написанные для роботов. Сейчас переспам текстов — большая проблема для оптимизаторов.

Чем опасно. Чем выше показатель тошноты текста, тем хуже для ранжирования. Самое плохое, что может случиться — сайт попадет под фильтры поисковых систем или опустится в выдаче. Пишите для людей, а не роботов.

Ошибки перелинковки

Перелинковка, или обмен ссылками — важный механизм повышения сайта в поисковой выдаче. Но всему есть предел. Слишком много ссылок дают обратный эффект. Обычно на одной странице не должно быть больше 400 внутренних и 1000 внешних ссылок. А еще на странице могут присутствовать битые и редиректные ссылки. И первых, и вторых должно быть как можно меньше. Это общие советы, а негласных правил перелинковки больше, чем анекдотов про Чапаева.

Чем опасно. Неправильная перелинковка грозит переоптимизацией, а битые и редиректные ссылки затрудняют индексацию страниц и отрицательно сказываются на лояльности пользователей. Как следствие — понижение позиций в выдаче.

Индексируемые дубли страниц

По аналогии с зеркалами сайта случается, что в поиск попадают страницы, которые дублируют контент друг друга. Так бывает, когда в файле robots.txt пропущены инструкции для поисковых роботов. Тогда бот индексирует страницы, которые не нужны в выдаче: фильтры товаров, страницы поиска или пагинации, которые дублируют контент разводящей. Чаще всего проблема решается корректной настройкой robots.txt или атрибутом rel=canonical.

Чем опасно. По аналогии с зеркалами, дубли страниц вредят продвижению — сайт понижается в результатах поиска

Прочитали? Теперь бегом на свои сайты

Эти десять недоработок технической оптимизации составляют 90 % от всех найденных ошибок. Тоже встречаются, но не попали в топ: ошибки в заголовках, наличие целевых страниц без скриптов сбора статистики, отсутствие настроенных целей в Яндекс.Метрике, большое количество целевых страниц с отказами, индексируемые поддомены.

Если вы нашли эти ошибки у себя, значит продвигаемый сайт теряет позиции на ровном месте. Быстрее исправляйте, а если не знаете как, спросите в комментариях — мы здесь для этого и собрались.