«Да я этот проект уже год веду! Все, что можно уже в нем сделал. Все в нем знаю!» – такими заявлениями любят бросаться SEO-специалисты, особенно начинающие. В действительности же у любого специалиста со временем взгляд на проект замыливается, да так, что можно не заметить явных проблем. Предлагаем краткий чек-лист, чтобы на скорую руку определить, не закрались ли где-то коварные ошибки, и проверить, весь ли потенциал сайта вы используете. Рекомендуем проходиться по этому списку минимум раз в месяц, чтобы держать руку на пульсе.

Исследование сайта любой полюбившейся утилитой – Xenu, Netpeak Spider, ScreamingFrogSEOSpider

Регулярно проверяйте сайт на наличие:

- дублей страниц. Они могут генерироваться системой управления из страниц пагинации, фильтров, сортировок, калькуляторов и многого другого;

- дублей title и description. Если у вас большой интернет-магазин, и вы настраивали шаблонную генерацию метатегов, функционал может давать сбои из-за внесенных позже доработок. Метатеги в таком случае дублируются, отчего сайт может хуже ранжироваться в поисковых системах;

- битых ссылок. Например, вы удалили страницы из структуры, убрали товар или категорию с сайта, переименовали URL без редиректа, а где-нибудь в тексте на сайте стояла ссылка на эту страницу – ее нужно найти и заменить на актуальную или вообще удалить.

- h1 на страницах. На каждой странице обязательно должен быть один h1! К сожалению, подобными программами не найти множественные заголовки первого уровня, но хотя бы их отсутствие можно установить;

- ЧПУ всех страниц. Часто бывает, что существует параллельно две версии страницы – с ЧПУ и с параметром. Это негативно сказывается на их ранжировании поисковыми системами;

- смешения латиницы и кириллицы в URL страницы. Подобно предыдущему примеру, может существовать две версии страницы – в латинском написании и в кириллическом. Это дубли, от которых нужно избавляться с помощью 301 редиректа;

- пустых и малоинформативных страниц. Их легко найти по наименьшему весу, но затем обязательно нужно проверить вручную. Если эти страницы действительно несут мало информации для пользователя и поисковых систем, их нужно заполнить уникальным контентом или закрыть от индексации.

Проверка в Яндекс.Вебмастере

Диагностика сайта. Смотрим ошибки и рекомендации, на их основе составляем ТЗ.

Поисковые запросы -> История запросов. Выберите «Популярные запросы за последний период» и скачайте в виде файла. Проанализировав эти данные, можно узнать:

- по каким фразам, кроме основных продвигаемых, есть показы и переходы, и при необходимости дополнить семантическое ядро;

- по каким словам не было переходов, но были показы. Нужно проработать сниппеты вашего сайта по этим запросам, ориентируясь на сниппеты конкурентов в топе;

- что на сайте вирус. В этом случае в поисковых словах появляются показы по странным, нерелевантным вашему сайту запросам из-за появления на нем инородного контента.

Индексирование -> Страницы в поиске. Посмотрите, какие последние изменения произошли: какие страницы выпали из индекса, а какие попали в него. Так удобно отлавливать «мусорные» страницы с ошибками или технической информацией, попавшие в индекс. На скриншоте ниже видно, что URL /catalog/prodazha-kvartir/&page=2&page=3&page=4 выбивается из общей структуры и явно лишний в индексе.

В этом же разделе Вебмастера можно узнать причину выпадения страницы из индекса и принять меры по исправлению ситуации. Те же данные, но в удобном для сортировок и фильтраций виде, рекомендуем выгрузить в файл xlsx или csv.

Проводить анализ в динамике не всегда удобно, особенно если сделать это нужно оперативно. Выгружайте отчеты из соседних вкладок «Все страницы» и «Исключенные страницы», чтобы увидеть актуальную картину по страницам, участвующим в поиске, и тем, которые были исключены из него с датой последнего изменения статуса.

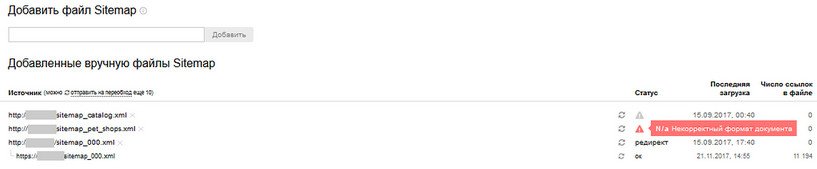

Индексирование -> файлы Sitemap.xml. Если в карте сайта появятся ошибки, то поисковый робот может неправильно распознать страницы и проиндексировать их неверно или вообще не включить в поисковую базу. Указанные ошибки важно устранить и отправить карту сайта на переобход.

Ссылки -> Внешние ссылки. Нередко на продвигаемый сайт появляются ссылки, о которых владелец ресурса даже не подозревает. Это могут быть происки конкурентов или результат того, что сайт попал в один из списков массового интернет-парсинга для создания спамного контента. Вариантов множество, и за это ресурсу грозит понижение позиций в поисковой выдаче. Если вовремя увидеть «лишние» ссылки и провести с Платоном Щукиным несколько переписок, можно добиться того, чтобы Яндекс не учитывал эту информацию при ранжировании.

В таблице удобно использовать группировку по сайтам:

Информация о сайте -> Региональность. Здесь достаточно проверить, верно ли присвоена сайту региональность. Бывает, что после очередной перепроверки региональность сайта меняется автоматически, а это ведет к падению позиций по геозависимым запросам.

Проверка в Google Search Console

Вид в поиске -> Оптимизация HTML. Google сам подсказывает, о каких дублях title и description он знает, какие метаописания считает слишком короткими или длинными, и где они вообще отсутствуют.

По каждой проблеме можно выгрузить подробную информацию в табличном виде:

Поисковый трафик -> Анализ поисковых запросов. Тут вы найдете то же, что в Яндекс.Вебмастере в разделе «История запросов». Обычно Google быстрее индексирует спамные страницы, а значит, и показы по подобным запросам появятся в Google Search Console оперативнее, чем в Яндекс.Вебмастере.

Сайт по разным запросам в Яндексе и Google имеет разные позиции, и сами запросы могут отличаться. Полезно использовать данные из обеих поисковых систем, чтобы получить максимум информации.

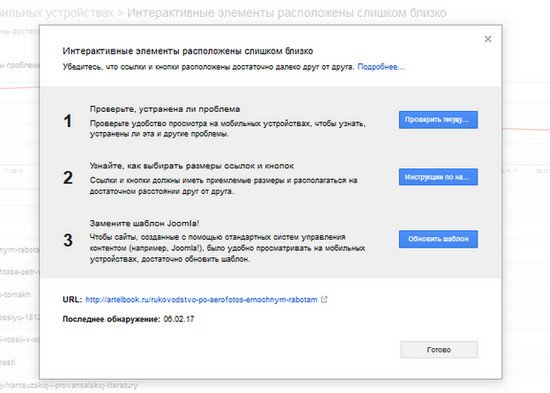

Поисковый трафик -> Удобство просмотра на мобильных устройствах. Эту проверку удобно делать именно в Search Console, так как сервис дает информацию сразу о всех страницах сайта, которые участвуют в поиске, и выделяет основные ошибки.

По каждому типу ошибки есть развернутое объяснение: каких именно страниц коснулась эта проблема и что делать, чтобы исправить ее. После внесения корректировок не забудьте отметить «Готово».

Сканирование -> Ошибки сканирования. В этом разделе хранится информация о страницах, для которых Google зафиксировал 404 код ответа сервера, например, если поисковый паук приходил в тот момент, когда сайт неожиданно перестал работать по техническим причинам, или страница была удалена.

При нажатии на каждый из приведенных URL вы увидите подробную информацию, где все еще стоят ссылки на недоступную страницу (другими словами, битые ссылки), и исправить ситуацию.

Сканирование -> Инструмент проверки файла robots.txt. Тут Google подсказывает, если в файл robots.txt закралась синтаксическая ошибка, отсутствует важная директива, не хватает знака препинания или файл сохранен в неверной кодировке.

Данные Яндекс.Метрики

Отчеты -> Источники -> Поисковые запросы. Аналог пунктов, связанных с анализом поисковых запросов в Яндекс.Вебмастере и Search Console. Зачем делать тройную проверку, спросите вы? Потому что данные, как ни странно, отличаются. В Метрике стоит обратить внимание на время, проведенное на странице, и нерелевантные запросы.

Отчеты -> Содержание -> Популярное. Этот раздел поможет найти аффилиаты, тестовые версии, поддомены и мусорные страницы, на которые попадали пользователи. На скриншоте видно, что был переход на защищенный протокол, а также на тестовую версию, которую необходимо проверить на наличие в поиске:

Отчеты -> Мониторинг -> Время загрузки страниц. Часто проверку скорости загрузки проводят в сервисах Google. Однако такой вариант не дает детальной информации, на каком этапе тормозится загрузка. Кроме того, проверку в нем приходится делать постранично, что замедляет процесс. Отчет Метрики дает понимание, на каком шаге происходит торможение, и показывает информацию сразу по всем страницам сайта. Первым делом ищите проблему по столбцам «Время до отрисовки» и «Время до загрузки DOM» в сильно выпадающих из норм значениях. Чтобы детально разобраться, в какой конкретно момент происходит сбой, используйте другие столбцы отчета.

Дополнительные проверки в поисковых выдачах

Сопоставьте число страниц в индексе и на сайте. Введите в выдачу обеих поисковых систем запрос site:domen.ru, посмотрите, сколько страниц находится в индексе и сравните с примерным числом страниц на сайте. Например, с помощью системы управления, sitemap.xml или с результатов работы SEO-парсера из пункта 1. Если разница в числе страниц большая, нужно исправлять ситуацию: либо что-то не индексируется, либо в поиск попало лишнее.

Введите в поиск номер телефона с сайта, адрес и название организации (по отдельности). Так можно обнаружить, что другие сайты компании индексируются даже выше продвигаемого или просто присутствуют в выдаче. Если такое случилось, нужно проверить их на аффилированность с основным продвигаемым сайтом.

Подводя итоги

Может показаться, что на такого рода проверку уйдет много времени. На самом деле, если каждая из указанных операций вам знакома, проделать их не составит труда и займет не больше 40-60 минут.

Конечно, этот чек-лист только обнаружит ошибки и покажет возможные пути их исправления. Для глубокого понимания проблемы и составления детального ТЗ потребуется больше времени и дополнительный анализ. Однако ценность этого аудита как раз в том, что он всегда дает пищу для размышлений, даже если прежде казалось, что с вашим сайтом все отлично.