Индексирующий робот Яндекса перестанет учитывать пустую директиву Allow как запрещающий сигнал в robots.txt.

Команда Яндекс.Поиска сообщила об изменениях в обработке директивы Allow в файле robots.txt. Теперь поисковые роботы Яндекса перестанут учитывать пустую директиву Allow как запрещающий сигнал в robots.txt.

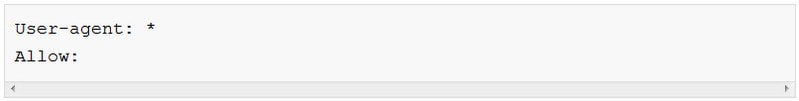

Ранее робот интерпретировал это правило как полностью запрещающее, что делало сайт недоступным для посещения роботов, и такие сайты не могли показываться в результатах поиска. Сейчас оно игнорируется при обнаружении в robots.txt.

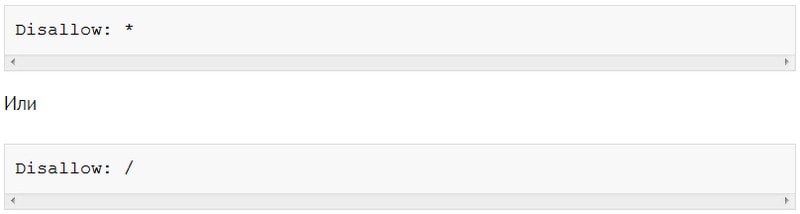

Если вебмастер намеренно использует пустое правило Allow в robots.txt, то для того, чтобы робот корректно учитывал запрет, правило нужно изменить на директиву Disallow:

Проверить, что разрешено, а что запрещено в robots.txt можно в Яндекс.Вебмастере. Команда поиска Яндекса рекомендует обратить особое внимание на пустые значения для Allow - если нужно запретить индексирование, то их быть не должно.

Важность корректного заполнения файла robots.txt трудно переоценить. Из-за несоблюдения определенных условий вебмастер может, как собственноручно ошибочно запретить доступ к своему сайту, так и рискует попаданием в результаты поиска тех файлов и документов, которые желал бы закрыть от индексации. Для того, чтобы все установленные директивы корректно использовались роботом при посещении сайта, необходимо соблюдать ряд условий, перечисленных ранее Платоном Щукиным.