Директор по SEO маркетингового агентства BoostROAS Роман Адэмицэ поделился интересным кейсом. Он примечателен тем, что в нём описывается метод, нарушающий рекомендации Google, но тем не менее эффективный. В частности, речь идёт об указании первой страницы в серии пагинации как канонической на e-commerce сайте.

Обычно вторая и последующая страницы категорий индексируемые, поскольку канонический тег показывает тот же URL (например, с параметром «?page=»). В BoostRoas хотели, чтобы индексировалась только первая страница категории. Поэтому канонические теги страниц пагинации были обновлены таким образом, чтобы они указывали на первую страницу. Когда Google доберётся до этих страниц, то уберёт их из результатов поиска.

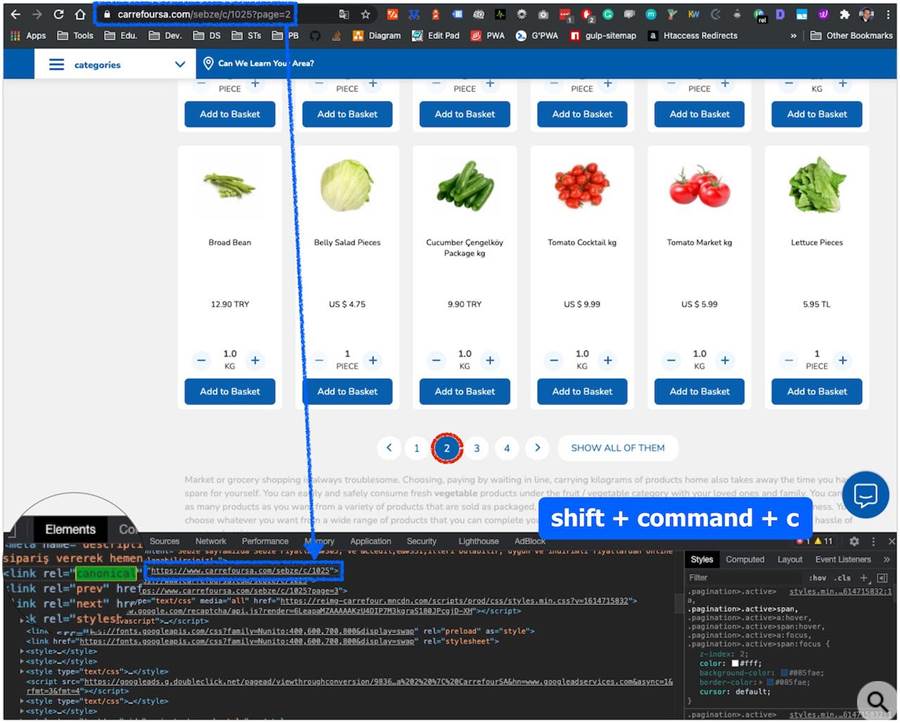

Пример серии пагинации на e-commerce сайте с указанием первой страницы как канонической:

Адэмицэ отмечает, что во многих статьях и даже в официальной документации Google этот метод не рекомендуется использовать. Есть мнения, что поисковик не найдёт товары, если страницы пагинации будут деиндексированы. Тем не менее, его опыт показывает, что использовать эту тактику можно. Негативных последствий не будет. Более того, можно ожидать положительных результатов.

В описанном кейсе процесс деиндексации страниц пагинации путём каноникализации первой страницы в серии пагинации был начат в декабре 2020 года. За 12 месяцев до этого изменения страницы с параметром «?page=» получили более 4 млн органических показов и почти 40 тыс. кликов. Внедрять задуманное было рискованно, однако SEO всегда сопряжено с рисками, отметил Адэмицэ .

На страницы пагинации не было обратных ссылок, что также важно, потому что их наличие затруднило бы деиндексацию.

После того, как страницы были удалены из индекса Google, в BoostROAS убрали их из файлов Sitemap XML.

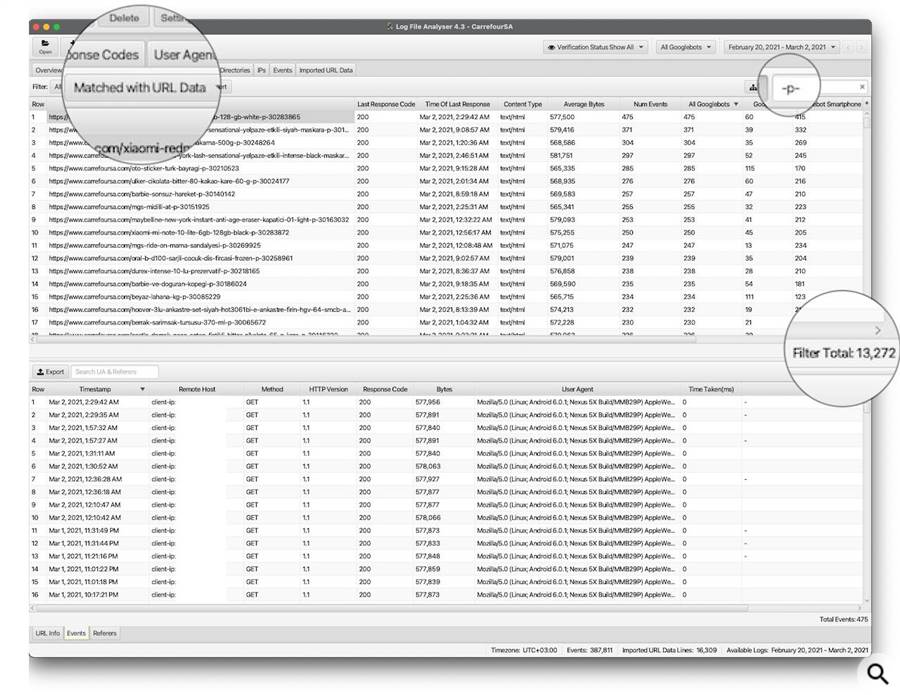

Всего таких страниц было 16 310.

- Может ли Google находить страницы пагинации

Да, может. За последнюю неделю Googlebot нашёл 13 272 URL. Что касается оставшихся 3038 URL, которые не были найдены, то это, вероятно, связано с ограниченными ресурсами на сканирование. Googlebot не сканирует каждую страницу сайта в один день или неделю.

- Почему этот метод стоит использовать

По мнению Адэмицэ, он даёт следующие преимущества:

- У Googlebot будет больше времени для сканирования более важных страниц.

- Вероятность того, что страницы пагинации появятся в топ-10 поисковой выдачи, очень низкая.

При этом Адэмицэ подчеркнул, что не призывает действовать вопреки рекомендациям Google. Просто, по его мнению, есть множество вещей, которые нужно тестировать. Без тестирования невозможно достичь хороших результатов.