- Поисковые системы

- Практика оптимизации

- Трафик для сайтов

- Монетизация сайтов

- Сайтостроение

- Социальный Маркетинг

- Общение профессионалов

- Биржа и продажа

- Финансовые объявления

- Работа на постоянной основе

- Сайты - покупка, продажа

- Соцсети: страницы, группы, приложения

- Сайты без доменов

- Трафик, тизерная и баннерная реклама

- Продажа, оценка, регистрация доменов

- Ссылки - обмен, покупка, продажа

- Программы и скрипты

- Размещение статей

- Инфопродукты

- Прочие цифровые товары

- Работа и услуги для вебмастера

- Оптимизация, продвижение и аудит

- Ведение рекламных кампаний

- Услуги в области SMM

- Программирование

- Администрирование серверов и сайтов

- Прокси, ВПН, анонимайзеры, IP

- Платное обучение, вебинары

- Регистрация в каталогах

- Копирайтинг, переводы

- Дизайн

- Usability: консультации и аудит

- Изготовление сайтов

- Наполнение сайтов

- Прочие услуги

- Не про работу

Как удалить плохие SEO-ссылки и очистить ссылочную массу сайта

Применяем отклонение ссылок

Сервис Rookee

Авторизуйтесь или зарегистрируйтесь, чтобы оставить комментарий

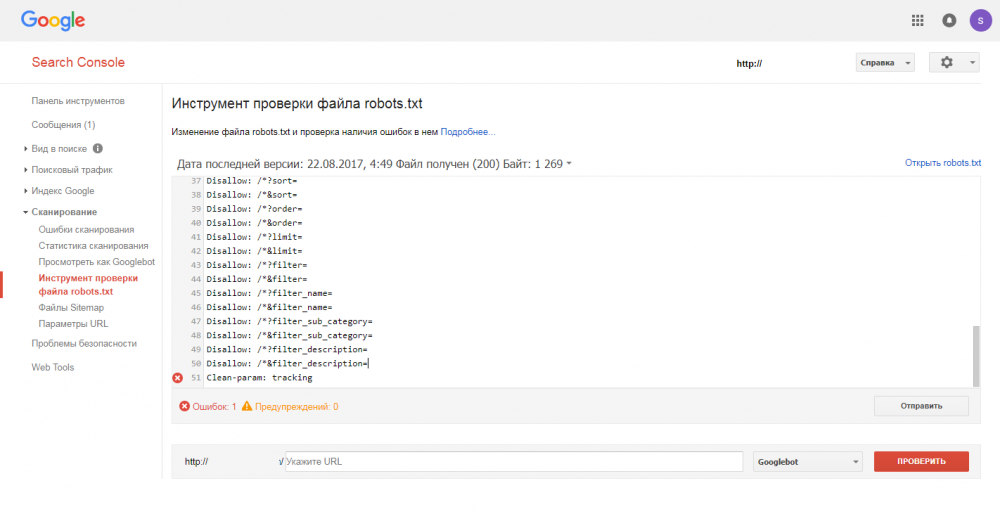

В Google Search Console -> в инструменте проверки файла robots.txt -> обнаружил ошибку в строке с директивой "Clean-param: tracking" (см. файл). Хочу исправить эту ошибку.

Подскажите плз.

Я так понимаю, что директива Clean-param является изобретением Яндекса (в Вебмастере ошибки нет), поэтому отсюда такая реакция.

п.с.

файл составлен машиной

знаю, что значение "tracking" для Clean-param: некорректно

знаю, что robots.txt особо не влияет ни на что

---------- Добавлено 23.08.2017 в 12:13 ----------

Перенесите эту директиву в раздел для User-agent:Yandex.

http://www.imgup.ru/image-27kjx111412124.html

Перенесите эту директиву в раздел для User-agent:Yandex.

Она там и находится (в конце):

User-agent: Yandex

Disallow: /*route=account/

Disallow: /*route=affiliate/

Disallow: /*route=checkout/

Disallow: /*route=product/search

Disallow: /index.php?route=product/product*&manufacturer_id=

Disallow: /admin

Disallow: /catalog

Disallow: /system

Disallow: /*?sort=

Disallow: /*&sort=

Disallow: /*?order=

Disallow: /*&order=

Disallow: /*?limit=

Disallow: /*&limit=

Disallow: /*?filter=

Disallow: /*&filter=

Disallow: /*?filter_name=

Disallow: /*&filter_name=

Disallow: /*?filter_sub_category=

Disallow: /*&filter_sub_category=

Disallow: /*?filter_description=

Disallow: /*&filter_description=

Clean-param: tracking

гугл не знает про эту Clean-param ничего, используйте её только для Яши

Перенесите эту директиву в раздел для User-agent:Yandex.

гугл не знает про эту Clean-param ничего, используйте её только для Яши

А это всё не важно. Даже если сделать отдельный блок в роботсе где для "User-agent: Googlebot" не прописывать Clean-param, он всё равно будет ругаться

А это всё не важно. Даже если сделать отдельный блок в роботсе где для "User-agent: Googlebot" не прописывать Clean-param, он всё равно будет ругаться

Т.е. нет возможности отговорить Гугл ругаться? Ну и ладно. Гугл всё равно не уважает роботс.

Похоже, что что-то поменялось.

Гугл теперь считается с файлом роботс, хотя-бы это видно из его интерфейса:

https://i.imgur.com/m6sJeES.png

И еще:

https://i.imgur.com/7bpkcMJ.png

Клиенты хотеть знать, не влияют ли не легитимные параметры в роботс от яндекса на гугл?

https://i.imgur.com/7a67QA8.png