- Поисковые системы

- Практика оптимизации

- Трафик для сайтов

- Монетизация сайтов

- Сайтостроение

- Социальный Маркетинг

- Общение профессионалов

- Биржа и продажа

- Финансовые объявления

- Работа на постоянной основе

- Сайты - покупка, продажа

- Соцсети: страницы, группы, приложения

- Сайты без доменов

- Трафик, тизерная и баннерная реклама

- Продажа, оценка, регистрация доменов

- Ссылки - обмен, покупка, продажа

- Программы и скрипты

- Размещение статей

- Инфопродукты

- Прочие цифровые товары

- Работа и услуги для вебмастера

- Оптимизация, продвижение и аудит

- Ведение рекламных кампаний

- Услуги в области SMM

- Программирование

- Администрирование серверов и сайтов

- Прокси, ВПН, анонимайзеры, IP

- Платное обучение, вебинары

- Регистрация в каталогах

- Копирайтинг, переводы

- Дизайн

- Usability: консультации и аудит

- Изготовление сайтов

- Наполнение сайтов

- Прочие услуги

- Не про работу

Что делать, если ваша email-рассылка попала в спам

10 распространенных причин и решений

Екатерина Ткаченко

Авторизуйтесь или зарегистрируйтесь, чтобы оставить комментарий

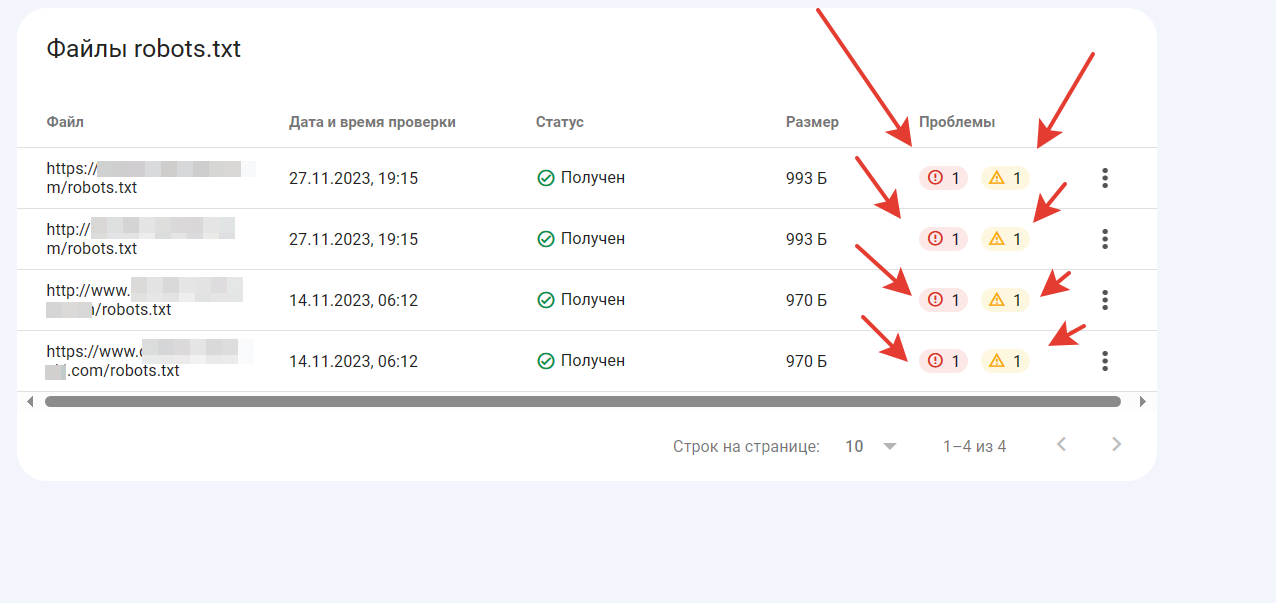

Ошибка в Search Console "Файлов с критическими ошибками: robots.txt" 1.ошибка Host 2.ошибка Sitemap. Приложил скрин для понимания. Кто-та сталкивался с такой проблемой? и как решали?

Протоколы разные.

четко

а по факту - карта сайта не нужна в роботсе - инструмента подачи карты в вебмастерах хватает с головой

Host удали, не работает давно (а когда работал то был только для Яндекса)

Да открывается

Да открывается

ну так роботс http а карта htttpS

Нет там 4 файла, просто скрин сделал http таже ошибка во всех 4

4

Нет там 4 файла, просто скрин сделал http таже ошибка во всех

а должен быть один , и сайт должен быть один с одним протоколом, все остальные 301 постраничным на него

Так он и один, это стандартное правило в Search Console так раньше было когда сайт добавляешь, сейчас не знаю много лет тому назад добавлял сайт. Ну проблема не в этом. Яндекс сам пишет вот что. Если кому интересно. А по поводу sitemap проблема остаётся открытая, Host удалил.

"увы, мы не можем комментировать работу сторонних сервисов. Отмечу, что директива Host не обрабатывается индексирующим роботом, поскольку её поддержка прекращена. Поскольку поддержка директивы прекращена, её добавление или удаление никак не повлияет на индексирование сайта. Что касается sitemap, то мы не рекомендуем убирать ссылку на него из файла robots.txt, поскольку так робот будет быстрее узнавать о страницах.!

Так он и один, это стандартное правило в Search Console так

я понял - мы смотрим доменный ресурс, там же 4 роботса.

а почему перенос строки у вас ? если переноса нету - просто удалите строку с картой и все

я понял - мы смотрим доменный ресурс, там же 4 роботса.

а почему перенос строки у вас ? если переноса нету - просто удалите строку с картой и все

Так Search Console сам их туда добавил ( 4 роботса ) когда через "подтверждение с помощью DNS". Какой перенос, который был после строки Sitemap, то это тоже не помогло.