12 марта 2015 года в Киеве прошла конференция для специалистов поисковой оптимизации SEMPRO 2015. В рамках конференции SEO-аналитик и автор профессионального SEO-блога devaka.ru Сергей Кокшаров представил доклад на тему «SEO-фишки, о которых вы могли не знать».

Фишки в области индексации

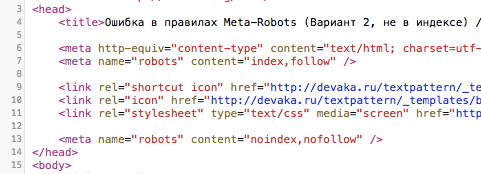

Ошибка в meta-robots отключает правила. В приведенном примере в meta-robots два противоречивых указания по поводу индексации контента все-таки привели к его индексации. При перемене спорных мета-тэгов местами происходило то же самое. Это значит, что следует следить за мета-тэгами и не давать противоречивых указаний.

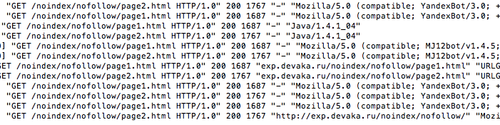

Яндекс следует по ссылкам на странице с «noindex» и «nofollow», но при этом все же не добавляет эти страницы в индекс. Если нужно закрыть какие-то страницы от Яндекса, следует предпринимать дополнительные меры.

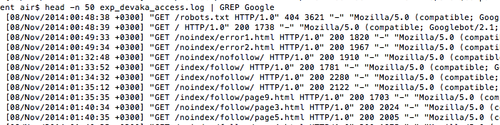

Google сначала индексирует страницы верхнего уровня. Когда следует проиндексировать новый сайт с определенной структурой, первой в индекс попадает главная страница. После этого, не зная структуры сайта, поисковик будет индексировать то, что находится ближе к слешу. Позже индексируются каталоги с двумя слешами. Это значит, что, даже если ссылки в контенте расположены высоко, они не обязательно будут проиндексированы первыми. Важно оптимально составить структуру, чтобы важные разделы не находились за большим количеством слешей, иначе Google решит, что это страница низкого уровня.

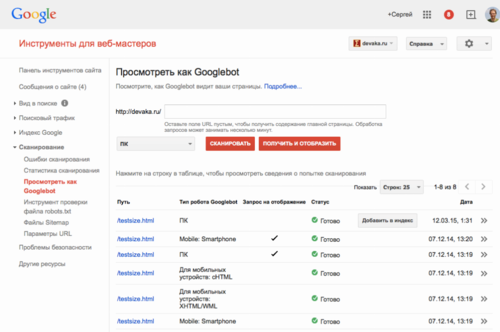

Добавить страницу в Google в течение нескольких минут можно сканированием в панели для веб-мастеров (пункт сканирование/посмотреть как Googlebot/добавить в индекс). Таким же образом можно быстро переиндексировать необходимые страницы.

Страницы в «соплях» (Supplemental Index, дополнительном индексе, запускаем только для самых низкочастотных запросов) дают минимум трафика – менее 1%. Но при этом у множества сайтов в дополнительном индексе находится чуть ли не половина всех страниц, и робот не эффективно использует свои ресурсы.

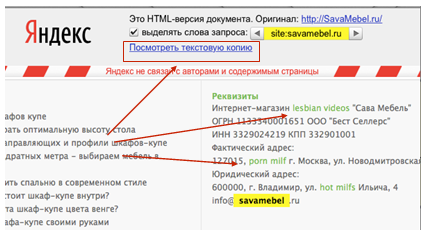

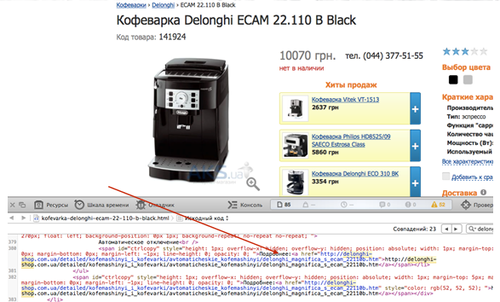

За ссылки на контент для взрослых Яндекс автоматически накладывает фильтр и выкидывает главную страницу сайта из индекса, при этом остальные страницы могут остаться. Следует внимательно следить за кэшем и появлением таких ссылок, особенно когда сайт подвергся взлому.

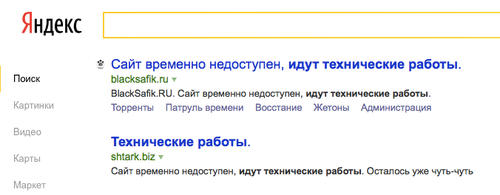

При проведении технических работ на сайте следует ставить 503 код статуса, чтобы поисковик не выкинул сайт из индекса. Если робот несколько раз зайдет на сайт, когда тот отключен для каких-то работ, можно потерять трафик. 503 код говорит поисковику о проводящихся работах и о том, что следует зайти позже.

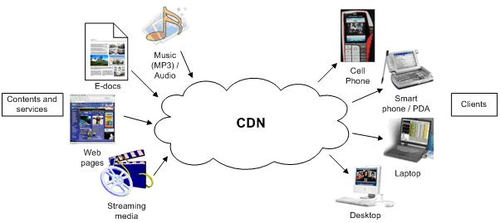

Поисковики нормально воспринимают сети дистрибуции контента (CDN) – отдельный сервер, где хранится вся статика и, в частности, изображения. Такие изображения попадают в поиск по картинкам, и с них приходит трафик на сайт.

Фишки оптимизации

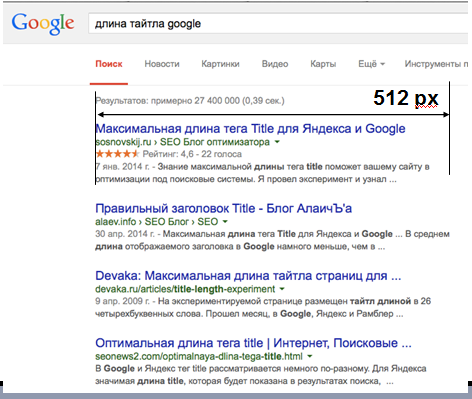

Ширина тайтла в Google измеряется в пикселях, а не в словах или символах. На тайтл отводится всего 512 пикселей, не поместившиеся символы будут обрезаться. Чтобы измерить тайтл, можно воспользоваться, например, PhotoShop.

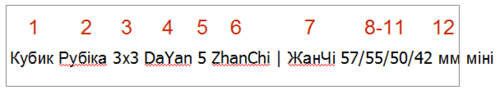

Google в тайтле учитывает всего 12 слов, все остальные идут как текст. Поэтому стоит следить за используемыми в тайтлах разделителями, а малоинформативные слова ставить в конец.

Google формирует тайтл из различных участков текста, в том числе и из Alt-изображений. Это зависит от запроса и спамности текущего тайтла. Если поисковик посчитает тайтл спамным, то возьмет для него другую информацию.

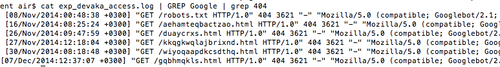

Google анализирует на сайте 404 страницу. В этом можно убедиться, посмотрев логи. На этой странице может тестироваться удобство пользования, поэтому она должна присутствовать, включая ссылки и текст. Вероятнее всего, удобная 404 страница будет плюсом для всего сайта.

Удаление даты публикации в контентном разделе сайта повышает трафик в Google. Эксперимент показал, что при удалении даты трафик незначительно проседал на непродолжительное время, после чего наблюдался его рост.

Сергей Кокшаров настоятельно рекомендует использовать только 301 редирект, избегая 302, так как использование последнего всегда сопровождается казусами и неприятностями.

Продвижение главной страницы по брендовым запросам снижает риск попадания в бан всего сайта. Некоторые продвигают сайт по высокочастотным запросам, но Google и Яндекс сейчас переходят к тому, чтобы сайты представляли себя брендами. Поэтому главную страницу лучше раскручивать по названию компании, особенно если на сайте присутствует множество разделов, реализованных в виде папок или поддоменов. В таком случае, если один из разделов попадет под бан, достаточно будет переименовать его и перенести на другой кластер, чтобы восстановить трафик на него.

Естественный текст ранжируется лучше, чем оптимизированный под поисковые системы. Не стоит использовать стандартные схемы с указанием количества вхождений и так далее. Достаточно написать естественный текст и упомянуть в нем ключевые слова.

На первые позиции в поиске попадают крупные и качественные изображения, а не оригиналы. Исходя из этого, докладчик рекомендует не сразу выкладывать самые высококачественные изображения из имеющихся, чтобы иметь возможность управлять их оригинальностью и не терять трафик из поиска по изображениям.

Ссылки и ранжирование

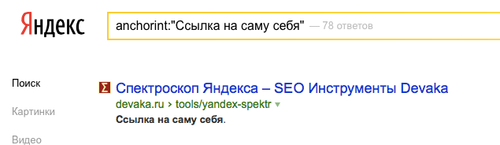

Ссылки со страницы на саму себя, обычно проставляемые с ключевиками внизу главной страницы, не работают.

Проверить внутреннюю ссылочную релевантность в Яндексе можно с помощью недокументированного оператора anchorint.

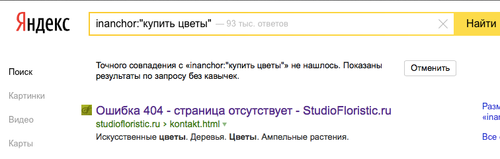

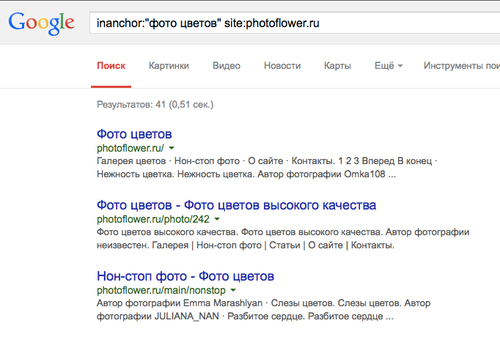

В Google аналогичную процедуру можно проделать, используя оператор inanchor. В отличие от оператора Яндекс, он находит все ссылки, а не только внутренние. Если подключить оператор site, то можно оценить, какие документы более всего релевантны, исходя из ссылочной релевантности. Полученные результаты можно сравнить и сделать вывод о том, не конкурируют ли страницы сайта между собой.

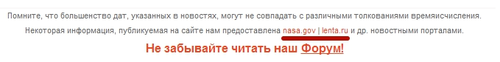

Соседняя ссылка на авторитетный ресурс автоматически усиливает значимость первой. Когда речь идет о статейном продвижении, в закупленной статье стоит проставлять ссылку не только на свой сайт, но и на другой авторитетный ресурс. Такие ссылки Google считает хорошими и придает им авторитет от проверенных ссылок.

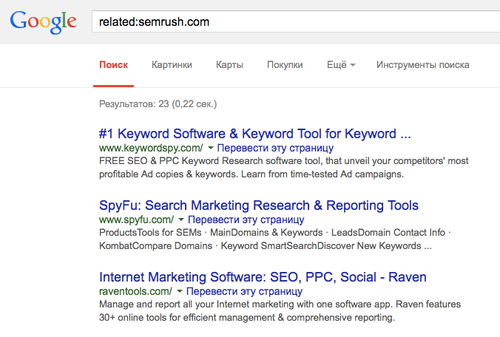

Оператор related в Google покажет, с какими сайтами ассоциируется исследуемый сайт в поисковой системе. В зарубежном Google давно уже ходит термин со-цитирование, означающий сайты, цитирующиеся вместе. Таким образом можно измерить авторитетность сайта. Если оператор покажет пустую выдачу или нехорошее соседство, тогда веб-мастеру следует поработать над этим и при публикации обзоров правильно размещать соответствующие ссылки.

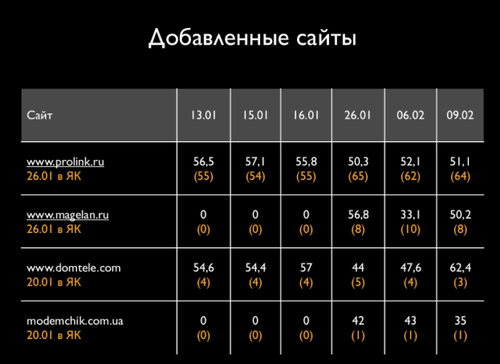

Яндекс.Каталог влияет не только на тИЦ, но и на ранжирование по запросам. Для этого вывода было проведено исследование рубрики в Яндекс.Каталоге, при котором отслеживалась видимость добавленных в рубрику сайтов. Оказалось, что при этом происходит резкий рост видимости сайта в поиске. При продвижении под Яндекс стоит учесть эту закономерность.

Добавление в буфер ссылки на источник при копировании текста работает лучше, чем полный запрет на копирование. Скрипты от копирования текста можно легко обойти, а ссылка на источник, особенно, если она скрыта от отображения, может принести обратные ссылки на сайт.

Перелинковка лучше работает, если ее делать из слов, найденных в сниппетах. Если в Google или Яндекс задать поиск по сайту по ключевым словам, поисковики сами подскажут, какие слова из описательной части они считают наиболее релевантными запросу.

Площадки для размещения ссылок подскажут конкуренты. Для этого можно использовать сервис ahrefs.

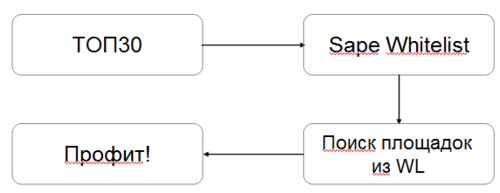

Если конкуренты продают ссылки в Sape, это один из тех случаев, когда она оказывается полезной. Следует мониторить, кто из конкурентов продает ссылки. Нужно взять пул своих основных запросов – ТОП30, добавить их в Whitelist и найти, какие из этих площадок продают ссылки, после чего на них можно купить ссылку на свой сайт с тем же текстом. Если раньше конкурент ранжировался выше, то спустя какое-то время он опустится в выдаче.

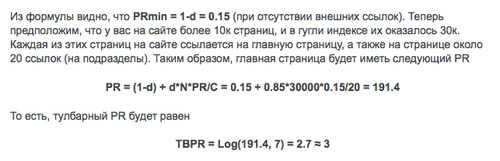

PageRank можно поднимать внутренними ссылками: чем больше страниц на сайте, тем лучше ранжирование. Идея в том, что маленькие сайты продвигать сложнее, а в многостраничных сайтах можно манипулировать внутренней перелинковкой. Несмотря на то, что тулбарный PageRank отключен, сам факт статического веса остается актуальным.

Другие фишки

Проверить сайты на одном IP можно с помощью Bing. Это может пригодиться, например, для нахождения всей сетки сайтов, в которой продвигается конкурент.

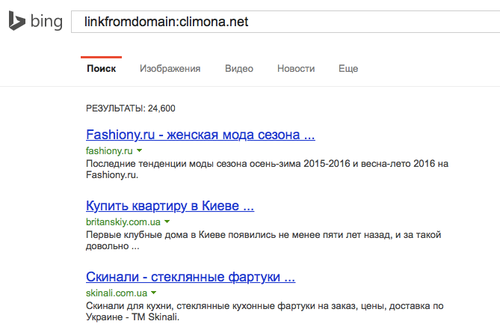

Проверить количество исходящих ссылок с сайта можно с помощью оператора linkfromdomain в Bing. Это можно использовать, когда сайту предлагают разместить ссылку. Важно, чтобы исходящих ссылок не было слишком много, иначе сайт может попасть под подозрение как ссылочная площадка.

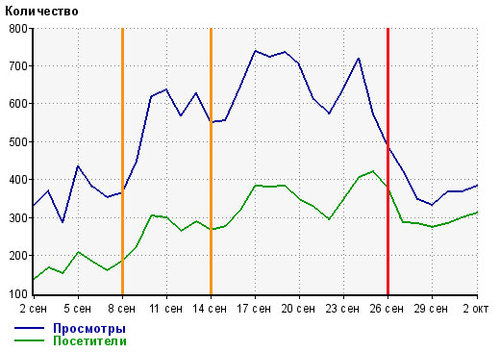

После обновления контента позиции сначала могут понизиться и лишь потом подняться, поэтому не стоит торопиться с выводами хотя бы пару дней.

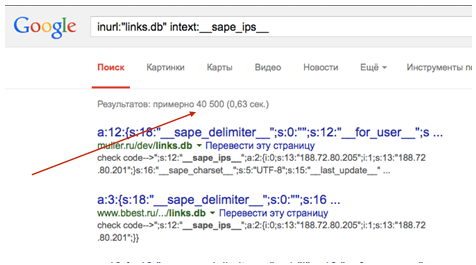

Найти сайты, которые продают ссылки, не сложно. Поиск links.db с текстом sape_ips выдает 40 тысяч сайтов, которые продают ссылки в Sape. Очевидно, что поисковик это тоже понимает.

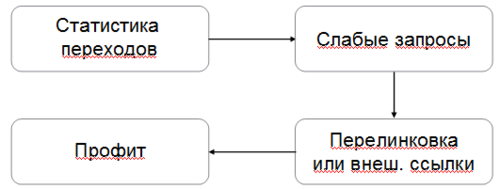

Проще всего поднять трафик по низкочастотным запросам, по которым сайт находится на 2-3 странице.

Расширить семантику на сайте можно с помощью добавления тематического словаря. В любой тематике есть свои специфические термины, и ими стоит воспользоваться.

Два домена лучше, чем один. Стоит разделить сайт на коммерческий и информационный домены и поддерживать коммерческий домен с информационного. Докупая контекст, таким образом можно занять 4 позиции в выдаче.

Трафик конкурента можно смотреть через li.ru. Если у конкурента стоит счетчик и он не закрыт, то можно увидеть его полную статистику.

В «хлебные крошки» можно добавлять призыв к действию или описание конкурентных преимуществ для повышения количества кликов.

В заключение Сергей Кокшаров раскрыл главный секрет поисковой оптимизации: никаких секретов не существует. Главное – постоянно работать над сайтом!